|

76 | 76 |

|

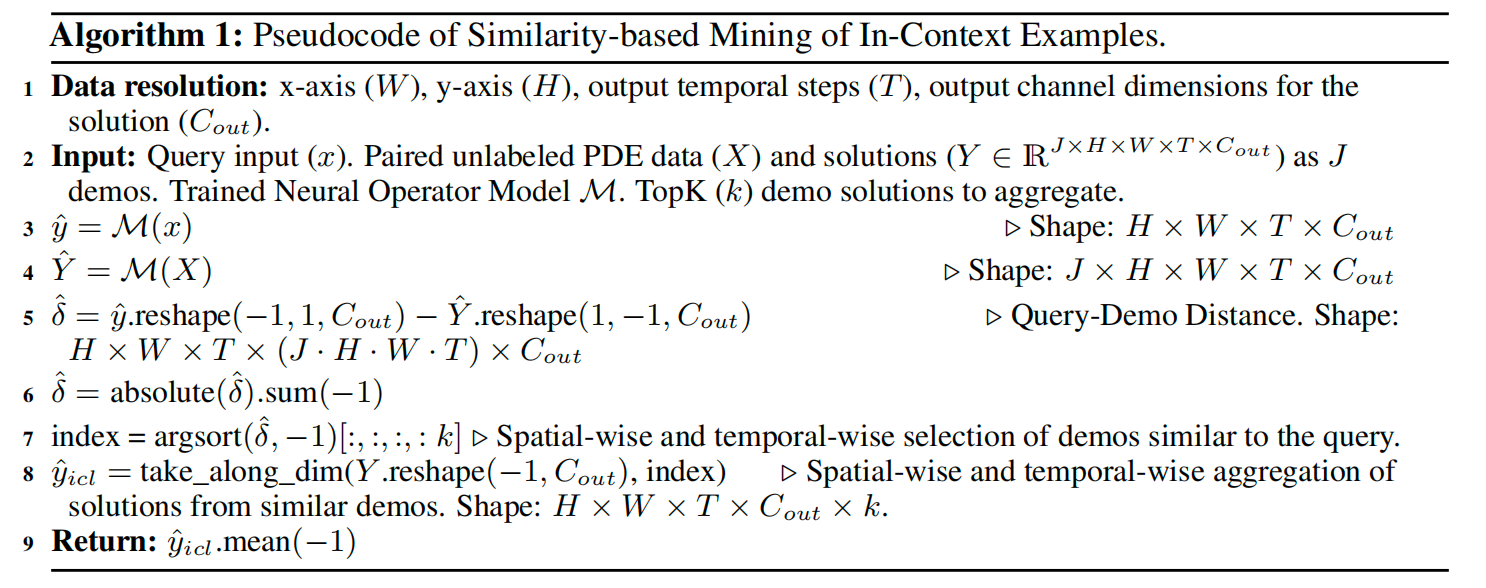

77 | 77 | 2. **其次,为了在预训练的基础上进一步显著增强模型在**分布外(Out-of-Distribution, OOD)**场景下的泛化性能和鲁棒性**,论文巧妙地引入了一种**基于相似性的上下文学习(Similarity-Based In-Context Learning)机制**。这种机制允许预训练的神经算子在**推理阶段**,以一种高度灵活且动态的方式,利用少量与当前查询输入在物理特性上高度相似的“上下文示例”(或称“演示样本”)来辅助其进行预测。这些上下文示例通常是从一个小型、高质的标记演示数据集中检索而来,包含与当前查询相似的物理参数输入及其对应的精确解。其关键在于,这种上下文学习机制**无需任何额外的训练成本或复杂的设计**,它是在模型已经完成预训练和/或微调的基础上,在推理时才发挥作用。模型首先计算当前查询输入与预先存储的上下文示例之间的相似度(例如通过高维特征空间的距离度量),然后利用这些被检索到的相似示例所蕴含的丰富信息,动态调整或优化其对当前查询的预测结果。这种非参数化的适应能力使得模型能够有效地适应并处理那些在训练阶段从未见过的、甚至超出其训练数据分布范围的物理条件,极大地提升了模型在复杂真实世界场景中的实用性和可靠性。 |

78 | 78 |

|

79 | | -论文对本框架在多组不同类型的PDEs上进行了广泛而深入的实证评估,涵盖了从线性到非线性的多种物理现象和复杂性,并验证了其在模拟真实世界场景中的有效性。实验结果以无可辩驳的证据有力地证明了论文方法所具备的卓越性能:它展现出惊人的**数据效率**,能够大幅削减对昂贵标记数据的需求,显著降低了数据生成成本;同时,模型通过无监督预训练内化了物理知识,使得其输出**具有更高的可解释性**,其预测结果更符合物理直觉,并能更好地反映底层的物理原理和结构;在处理复杂物理问题时,模型表现出**显著的优越性能**,其预测精度和鲁棒性均达到甚至超越了当前领域的领先水平。尤其值得注意的是,论文的方法在某些关键指标上甚至**超越了在通用图像或视频数据集上预训练的传统视觉预测模型**,这进一步凸显了其在科学计算领域,尤其是在解决当前普遍面临的**数据稀缺性问题**上所蕴含的巨大潜力。因此,本研究的背景旨在直击神经算子在**数据效率方面的核心痛点**,寻求一种能够有效利用海量廉价无标签物理数据的方法,以期**显著减少对昂贵PDE解数据的依赖**,从而最终使神经算子在更广泛的实际科学和工程应用中变得更具**可行性、普适性和成本效益**。 |

| 79 | +论文对本框架在多组不同类型的PDEs上进行了广泛而深入的实证评估,涵盖了从线性到非线性的多种物理现象和复杂性,并验证了其在模拟真实世界场景中的有效性。实验结果以无可辩驳的证据有力地证明了论文方法所具备的卓越性能:它展现出惊人的**数据效率**,能够大幅削减对昂贵标记数据的需求,显著降低了数据生成成本;同时,模型通过无监督预训练内化了物理知识,使得其输出**具有更高的可解释性**,其预测结果更符合物理直觉,并能更好地反映底层的物理原理和结构;在处理复杂物理问题时,模型表现出**显著的优越性能**,其预测精度和鲁棒性均达到甚至超越了当前领域的领先水平。尤其值得注意的是,论文的方法在某些关键指标上甚至**超越了在通用图像或视频数据集上预训练的传统视觉预测模型**,这进一步凸显了其在科学计算领域,尤其是在解决当前普遍面临的**数据稀缺性问题**上所蕴含的巨大潜力。因此,本研究的背景旨在直击神经算子在**数据效率方面的核心痛点**,寻求一种能够有效利用海量廉价无标签物理数据的方法,以期**显著减少对昂贵PDE解数据的依赖**,从而最终使神经算子在更广泛的实际科学和工程应用中变得更具**可行性、普适性和成本效益**。· |

80 | 80 |

|

81 | 81 | ## 2. 问题定义 |

82 | 82 |

|

@@ -143,6 +143,8 @@ $$\sum_{i,j=1}^{n}a_{ij}(x)u_{{x_i}{x_j}}+\sum_{i=1}^n{b_i(x)u_{x_i}}+c(x)u=f(x) |

143 | 143 |

|

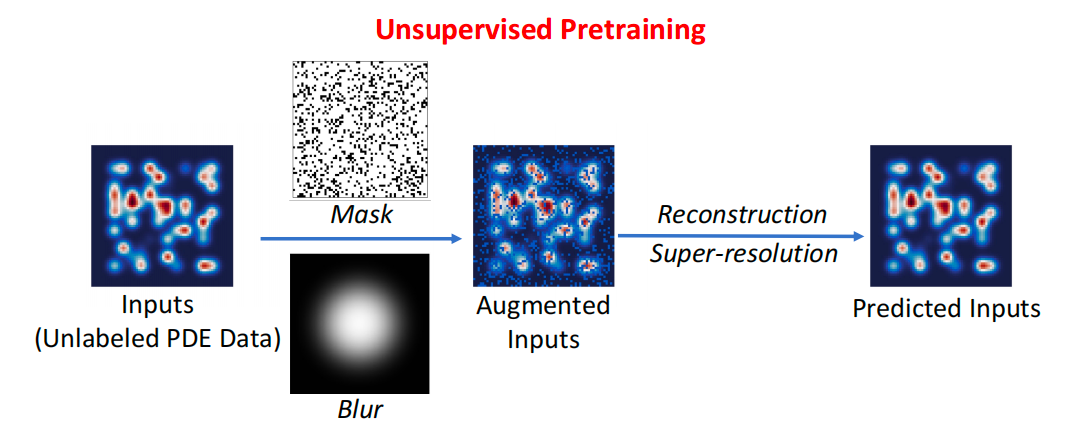

144 | 144 | 首先,论文引入了掩码自编码器(Masked Autoencoders, MAEs)。MAEs已被广泛证明是具有卓越可扩展性的自监督学习范式,其学习能力令人瞩目。该方法在概念上极为简洁却异常有效:通过策略性地移除输入数据中的一部分内容(即进行“掩码”操作),模型被训练来精确预测并恢复这些被移除的信息。正是这种强大的自我监督机制,使得MAEs在自然语言处理(NLP)领域能够训练出规模庞大、参数量超过千亿的通用模型,并在计算机视觉(CV)领域同样展现出颠覆性的潜力。在此研究中,论文深入探索了MAEs在科学建模,特别是PDE领域中的应用价值和深层潜力。其核心动机在于:PDE所描述的动力学过程对于全场科学数据的稀疏感知具有内在的不变性。换言之,无论数据是完整呈现还是仅通过稀疏的传感器采集,底层的物理规律都应保持一致。在现实世界中,科学数据常常不可避免地需要从离散或稀疏的传感器网络中进行收集,因此,重建或生成缺失传感器区域的数据成为一项极其常见且关键的任务。论文通过引入随机掩码机制,强制模型学习对传感器稀疏性的不变性,从而使其能够从无标签PDE数据的各种扭曲视图中有效提取出那些不随观测条件变化的本质特征。这种对科学数据稀疏感知的不变性属性的学习,将显著增强MAE所学习到的数据表示的鲁棒性和实用性。 |

145 | 145 |

|

| 146 | + |

| 147 | + |

146 | 148 | 因此,论文将MAE作为一个核心代理任务来加以利用。具体而言,论文构建的MAE是一种直接的自编码方法,其核心功能在于在仅给定部分观测数据的情况下,精确地重建出原始完整的信号。如同所有自编码器架构一样,论文的方法包含一个编码器模块,负责将输入的观测信号有效映射到一个紧凑且富有信息量的潜在表示空间;同时,它也包含一个解码器模块,其任务是基于这个潜在表示,高质量地重建出原始的完整信号。在实施掩码操作时,论文根据预设的掩码比率(即数据中被移除区域所占的比例)进行随机采样,并将被选定为掩码区域的无标签PDE数据值设置为零。论文所采用的损失函数是计算重建输入与原始输入之间在数学上的均方误差(MSE)。值得注意的是,论文仅在被掩码的区域上计算此损失;如果未进行任何掩码操作(即等同于一个普通的自编码器),MSE损失则将应用于所有空间区域,这将削弱其学习缺失信息的能力。 |

147 | 149 |

|

148 | 150 | 其次,论文引入了**超分辨率(Super-Resolution, SR)**作为另一个关键代理任务。SR技术已经发展成为一种极其强大的工具,能够有效增强数据的分辨率,从而提升数据表示的整体质量和保真度,并有助于恢复数据中精细尺度的结构和细节。从本质上讲,SR是一项涉及从对应的粗粒度数据中精确恢复或推断出精细尺度数据的任务。在PDE学习领域,SR同样是一个备受关注且广受欢迎的任务,其目标在于训练科学机器学习(SciML)模型,使其能够严格保留科学数据固有的物理特性。SR作为代理任务的动机在于:PDE的数值解理应展现出对滤波模糊或不同分辨率输入的不变性。例如,在复杂的湍流模拟中,由于固有的数值误差和计算限制,传统的数值方法常常难以在低分辨率网格上准确模拟出预期的物理现象。在这种背景下,SR已经成为PDE动力学中子网格建模的强大工具,对于捕捉湍流的关键模式和能量级联过程尤其具有显著的辅助作用。因此,给定特定的输入数据分布,在成功拟合超分辨率目标之后,论文期待神经算子能够自然地保留数据中固有的物理特性,并表现出对滤波模糊的强大不变性。鉴于此,论文将SR作为另一个至关重要的代理任务引入到模型训练中。论文在此次研究中采用SR的目标与近年来SciML领域中SR工作的核心动机保持一致。具体来说,论文通过SR强制模型学习对分辨率变化和模糊效应不敏感的无标签PDE数据中的不变特征。当数据分辨率过低,无法准确捕捉原始内容中的精细细节时,常常会导致图像或数据快照出现模糊现象。为此,论文策略性地对无标签PDE数据应用高斯滤波器进行模糊处理。与使用固定模糊不同,论文从预设的方差范围中随机采样高斯滤波器的方差,作为一种数据增强手段,从而使得自编码器被强制要求重建出具有精细细节的高分辨率原始输入。这一过程促使模型学习到从低质量、模糊或低分辨率输入中恢复高质量、清晰数据的能力,从而在面对实际应用中可能出现的数据质量问题时,模型的鲁棒性和准确性得以显著提升。 |

@@ -183,6 +185,8 @@ $$\sum_{i,j=1}^{n}a_{ij}(x)u_{{x_i}{x_j}}+\sum_{i=1}^n{b_i(x)u_{x_i}}+c(x)u=f(x) |

183 | 185 |

|

184 | 186 | 2. 聚合。 对于查询的每个空间-时间位置,在找到其在演示中的相似样本后,论文聚合并平均它们的解作为预测 。 |

185 | 187 |

|

| 188 | + |

| 189 | + |

186 | 190 | ## 4. 完整代码 |

187 | 191 |

|

188 | 192 | ``` py linenums="1" title="examples/data_efficient_nopt/data_efficient_nopt.py" |

@@ -236,9 +240,11 @@ examples/data_efficient_nopt/data_efficient_nopt.py |

236 | 240 |

|

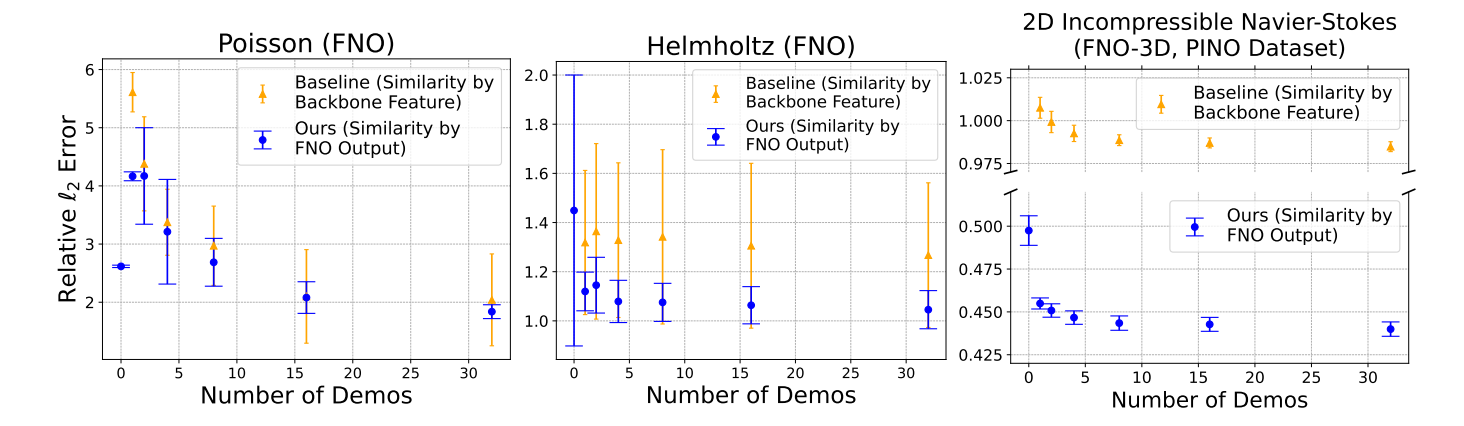

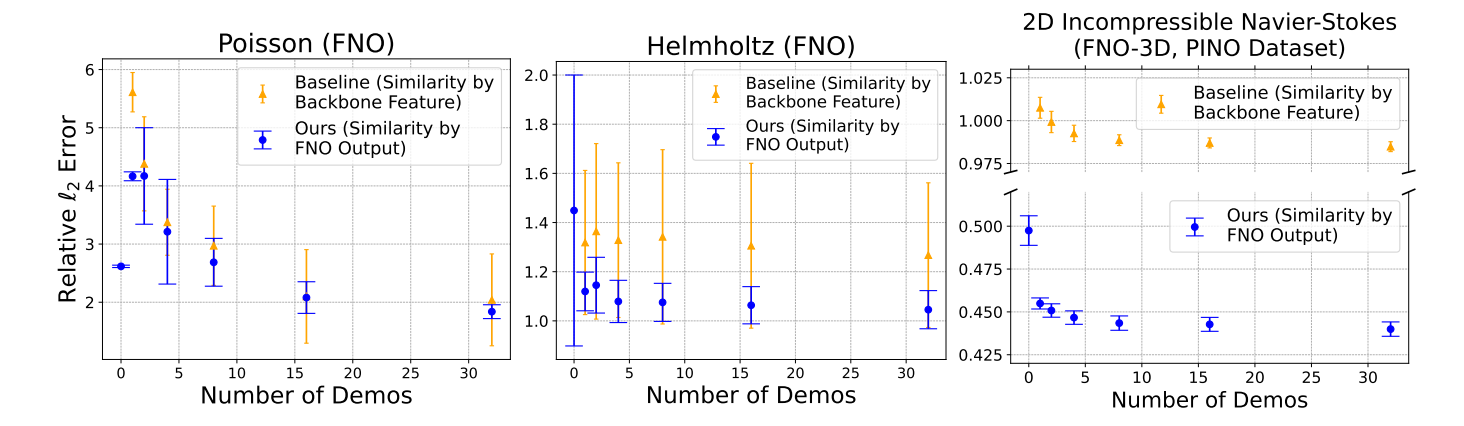

237 | 241 | 图3体现该种方法在情景推理场景中,超越了现有的通用预训练模型,具有额外泛化优势。 |

238 | 242 |

|

239 | | - |

| 243 | + |

| 244 | + |

| 245 | +总而言之,这篇论文提出了一种创新且高效的神经算子学习框架,通过无监督预训练在大量廉价的无标签物理数据上学习通用表示,并通过情境学习在推理阶段利用少量相似案例来提升OOD泛化能力。这一框架显著降低了对昂贵模拟数据的需求,并提高了模型在复杂物理问题中的适应性和泛化性,为科学机器学习的数据高效发展开辟了新途径。通过不同模型上实际数据与预测误差的对比,验证了该论文优秀的泛化性。 |

240 | 246 |

|

241 | | -总而言之,这篇论文提出了一种创新且高效的神经算子学习框架,通过无监督预训练在大量廉价的无标签物理数据上学习通用表示,并通过情境学习在推理阶段利用少量相似案例来提升OOD泛化能力。这一框架显著降低了对昂贵模拟数据的需求,并提高了模型在复杂物理问题中的适应性和泛化性,为科学机器学习的数据高效发展开辟了新途径。 |

| 247 | + |

242 | 248 |

|

243 | 249 | ## 6. 参考资料 |

244 | 250 |

|

|

0 commit comments