>`

+ - Llama 3 utilise des balises `<|system|>` avec des fins ``

+ - Mistral inclut un message système dans la première instruction

+ - Qwen utilise le rôle `system` explicite avec les balises `<|im_start|>`

+ - ChatGPT utilise le préfixe `SYSTEM:`

+

+2. **Délimitation des messages**:

+ - Llama 2 utilise les balises `[INST]` et `[/INST]`

+ - Llama 3 utilise des balises spécifiques pour chaque rôle (`<|system|>`, `<|user|>`, `<|assistant|>`) avec `` comme fin

+ - Mistral utilise `[INST]` et `[/INST]` avec `` utilise ``

+ - Qwen utilise des *token* de début et de fin spécifiques pour chaque rôle

+

+3. **Tokens spéciaux**:

+ - Llama 2 utilise `` et `` pour les limites de la conversation

+ - Llama 3 utilise `` pour terminer chaque message

+ - Mistral utilise `` et `` pour les limites des tours

+ - Qwen utilise des *token* de début et de fin spécifiques pour chaque rôle

+

+Comprendre ces différences est essentiel pour travailler avec différents modèles. Voyons comment la bibliothèque 🤗 *Transformers* nous aide à gérer ces variations automatiquement :

+

+```python

+from transformers import AutoTokenizer

+

+# Cela utilisera automatiquement des gabarits différents

+mistral_tokenizer = AutoTokenizer.from_pretrained("mistralai/Mistral-7B-Instruct-v0.1")

+qwen_tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat")

+smol_tokenizer = AutoTokenizer.from_pretrained("HuggingFaceTB/SmolLM2-135M-Instruct")

+

+messages = [

+ {"role": "system", "content": "You are a helpful assistant."},

+ {"role": "user", "content": "Hello!"},

+]

+

+# Chaque modèle sera formaté en fonction de son gabarit

+mistral_chat = mistral_tokenizer.apply_chat_template(messages, tokenize=False)

+qwen_chat = qwen_tokenizer.apply_chat_template(messages, tokenize=False)

+smol_chat = smol_tokenizer.apply_chat_template(messages, tokenize=False)

+```

+

+

+Cliquer pour voir des exemples de gabarits

+

+Gabarits ChatML de Qwen 2 et SmolLM2 :

+

+```sh

+<|im_start|>system

+You are a helpful assistant.<|im_end|>

+<|im_start|>user

+Hello!<|im_end|>

+<|im_start|>assistant

+Hi! How can I help you today?<|im_end|>

+<|im_start|>user

+What's the weather?<|im_start|>assistant

+```

+

+Gabarit de Mistral :

+

+```sh

+[INST] You are a helpful assistant. [/INST]

+Hi! How can I help you today?

+[INST] Hello! [/INST]

+```

+

+

+

+

+### Fonctionnalités avancées

+Les gabarits de chat peuvent gérer des scénarios plus complexes que les simples interactions conversationnelles, notamment :

+

+1. **Utilisation d'outils** : lorsque les modèles doivent interagir avec des outils externes ou des API.

+2. **Entrées multimodales** : pour gérer les images, le son ou d'autres types de médias

+3. **Appel de fonction** : pour l'exécution de fonctions structurées

+4. **Contexte multi-tour** : pour conserver l'historique des conversations

+

+

+Lors de l'implémentation de fonctions avancées :

+- Testez minutieusement votre modèle. Les applications de vision et les outils utilisent des gabarits particulièrement variés.

+- Surveillez attentivement l'utilisation des tokens entre chaque fonctionnalité et chaque modèle.

+- Documenter le format attendu pour chaque fonctionnalité

+

+

+Pour les conversations multimodales, les gabarits peuvent inclure des références d'images ou des images codées en base64 :

+```python

+messages = [

+ {

+ "role": "system",

+ "content": "You are a helpful vision assistant that can analyze images.",

+ },

+ {

+ "role": "user",

+ "content": [

+ {"type": "text", "text": "What's in this image?"},

+ {"type": "image", "image_url": "https://example.com/image.jpg"},

+ ],

+ },

+]

+```

+

+Voici un exemple de gabarits de chat avec l'utilisation d'un outil :

+

+```python

+messages = [

+ {

+ "role": "system",

+ "content": "You are an AI assistant that can use tools. Available tools: calculator, weather_api",

+ },

+ {"role": "user", "content": "What's 123 * 456 and is it raining in Paris?"},

+ {

+ "role": "assistant",

+ "content": "Let me help you with that.",

+ "tool_calls": [

+ {

+ "tool": "calculator",

+ "parameters": {"operation": "multiply", "x": 123, "y": 456},

+ },

+ {"tool": "weather_api", "parameters": {"city": "Paris", "country": "France"}},

+ ],

+ },

+ {"role": "tool", "tool_name": "calculator", "content": "56088"},

+ {

+ "role": "tool",

+ "tool_name": "weather_api",

+ "content": "{'condition': 'rain', 'temperature': 15}",

+ },

+]

+```

+

+## Bonnes pratiques

+

+### Principes généraux

+Lorsque vous travaillez avec des gabarits de chat, respectez les pratiques suivantes :

+

+1. **Formatage cohérent** : Utilisez toujours le même format de gabarits pour l'ensemble de votre application.

+2. **Définition claire des rôles** : Spécifiez clairement les rôles (système, utilisateur, assistant, outil) pour chaque message.

+3. **Gestion du contexte** : Tenir compte de la limite du nombre de *tokens* lors de la gestion de l'historique des conversations.

+4. **Gestion des erreurs** : Inclure une gestion appropriée des erreurs pour les appels d'outils et les entrées multimodales.

+5. **Validation** : Valider la structure du message avant de l'envoyer au modèle

+

+

+

+Les pièges à éviter :

+- Mélanger différents gabarits dans la même application

+- Dépasser la limite du nombre de token avec de longs historiques de conversation

+- Ne pas escamoter correctement les caractères spéciaux dans les messages

+- Oublier de valider la structure des messages d'entrée

+- Ignorer les exigences de gabarits spécifiques à un modèle

+

+

+## Exercice pratique

+

+Entraînons-nous à mettre en œuvre des gabarits de chat à l'aide d'un exemple concret.

+

+

+Suivez les étapes suivantes pour convertir le jeu de données `HuggingFaceTB/smoltalk` au format ChatML :

+

+1. Chargez le jeu de données :

+```python

+from datasets import load_dataset

+

+dataset = load_dataset("HuggingFaceTB/smoltalk")

+```

+

+2. Créer une fonction de traitement :

+```python

+def convert_to_chatml(example):

+ return {

+ "messages": [

+ {"role": "user", "content": example["input"]},

+ {"role": "assistant", "content": example["output"]},

+ ]

+ }

+```

+

+3. Appliquer le gabarit de chat en utilisant le *tokenizer* du modèle choisi.

+

+N'oubliez pas de vérifier que le format de sortie correspond aux exigences du modèle choisi !

+

+

+## Ressources complémentaires

+

+- [Guide sur les gabarits de chat dans la documentation d'Hugging Face](https://huggingface.co/docs/transformers/main/en/chat_templating)

+- [Documentation de 🤗 *Transformers*](https://huggingface.co/docs/transformers)

+- [Dépôt Github contenant des exemples de gabarits de chat](https://github.com/chujiezheng/chat_templates)

\ No newline at end of file

diff --git a/chapters/fr/chapter11/3.mdx b/chapters/fr/chapter11/3.mdx

new file mode 100644

index 000000000..5a4616456

--- /dev/null

+++ b/chapters/fr/chapter11/3.mdx

@@ -0,0 +1,374 @@

+

+

+# *Finetuning* supervisé

+

+Le *finetuning* supervisé (SFT) est un processus principalement utilisé pour adapter des modèles de langage pré-entraînés afin qu'ils suivent des instructions, engagent un dialogue et utilisent des formats de sortie spécifiques. Alors que les modèles pré-entraînés ont des capacités générales impressionnantes, le SFT permet de les transformer en modèles de type assistant qui peuvent mieux comprendre et répondre aux instructions de l'utilisateur. Pour ce faire, il faut généralement entraîner sur des jeux de données de conversations et d'instructions écrites par des humains.

+

+Cette page fournit un guide étape par étape pour finetuner le modèle [`deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B`](https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B) en utilisant le [`SFTTrainer`](https://huggingface.co/docs/trl/en/sft_trainer). En suivant ces étapes, vous pouvez adapter le modèle pour effectuer des tâches spécifiques plus efficacement.

+

+## Quand utiliser le SFT ?

+

+Avant de se lancer dans son implémentation, il est important de comprendre quand le SFT est le bon choix pour votre projet. Dans un premier temps, vous devez vous demander si l'utilisation d'un modèle existant instruit avec des instructions bien conçues suffirait pour votre cas d'utilisation. Le SFT implique des ressources de calcul et des efforts d'ingénierie considérables, et ne doit donc être envisagé que lorsque les instructions des modèles existants s'avèrent insuffisantes.

+

+

+N'envisagez le SFT que si vous :

+- Vous avez besoin de performances supplémentaires par rapport à ce que les instructions peuvent réaliser.

+- Vus avez un cas d'utilisation spécifique pour lequel le coût d'utilisation d'un grand modèle polyvalent l'emporte sur le coût du *finetuning* d'un modèle plus petit

+- Vous avez besoin de formats de sortie spécialisés ou de connaissances spécifiques à un domaine que les modèles existantsne maîtrisent pas.

+

+

+Si vous déterminez que le SFT est nécessaire, la décision de procéder dépend de deux facteurs principaux :

+

+### Contrôle des gabarits

+Le SFT permet un contrôle précis de la structure de sortie du modèle. Ceci est particulièrement utile lorsque vous avez besoin que le modèle :

+1. Génére des réponses dans un format de gabarits de chat spécifique.

+2. Suivre des schémas de sortie stricts

+3. Maintenir un style cohérent dans les réponses

+

+### Adaptation au domaine

+Lorsque l'on travaille dans des domaines spécialisés, le SFT permet d'aligner le modèle sur les impératifs propres au domaine en :

+1. Enseignant la terminologie et les concepts du domaine

+2. Appliquant les normes professionnelles

+3. Traitant les questions techniques de manière appropriée

+4. Suivant les lignes directrices spécifiques à l'industrie

+

+

+Avant de commencer à utiliser le SFT, évaluez si votre cas d'utilisation nécessite :

+- un formatage précis des résultats

+- des connaissances spécifiques à un domaine

+- des schémas de réponse cohérents

+- le respect de lignes directrices spécifiques.

+

+Cette évaluation vous aidera à déterminer si le SFT est la bonne approche pour vos besoins.

+

+

+## Préparation du jeu de données

+

+Le processus de *finetuning* supervisé nécessite un jeu de données spécifique à la tâche, structuré avec des paires entrée-sortie. Chaque paire doit comprendre

+1. Une instruction d'entrée

+2. La réponse attendue du modèle

+3. Tout contexte ou métadonnée supplémentaire

+

+La qualité de vos données d'entraînement est cruciale pour un *finetuning* réussi. Voyons comment préparer et valider votre jeu de données :

+

+

+

+## Configuration de l'entraînement

+

+La configuration de `SFTTrainer` nécessite la prise en compte de plusieurs paramètres qui contrôlent le processus d`entrainement. Examinons chaque paramètre et son utilité :

+

+1. **Paramètres concernant la durée de l'entraînement**:

+ - `num_train_epochs`: Contrôle la durée totale de l'entraînement

+ - `max_steps`: Alternative aux époques, définit le nombre maximum d'étapes d'entraînement.

+ - Un plus grand nombre d'époques permet un meilleur apprentissage, mais risque d'entraîner un surentraînement.

+

+2. **Paramètres concernant la taille des batchs**:

+ - `per_device_train_batch_size`: Détermine l'utilisation de la mémoire et la stabilité de l'entraînement

+ - `gradient_accumulation_steps`: Permet d'augmenter la taille des batchs

+ - Des lots batchs plus grands permettent d'obtenir des gradients plus stables mais nécessitent plus de mémoire

+

+3. **Paramètres concernant le taux d'apprentissage**:

+ - `learning_rate`: Contrôle les mises à jour de la taille des poids

+ - `warmup_ratio`: Partie de l'entraînement utilisée pour l'échauffement du taux d'apprentissage

+ - Un taux trop élevé peut provoquer une instabilité, un taux trop faible entraîne un apprentissage lent.

+

+4. **Paramètres de contrôle**:

+ - `logging_steps`: Fréquence de l'enregistrement des métriques

+ - `eval_steps`: Fréquence d'évaluation sur les données de validation

+ - `save_steps`: Fréquence des sauvegardes des points de contrôle du modèle

+

+

+Commencez par des valeurs prudentes et ajustez-les en fonction du contrôle :

+- Commencer avec 1-3 époques

+- Utiliser des batchs de plus petite taille dans un premier temps

+- Surveiller de près les métriques de validation

+- Ajuster le taux d'apprentissage si l'entraînement est instable

+

+

+## Implémentation avec TRL

+

+Maintenant que nous comprenons les composants clés, mettons en œuvre l'entraînement avec une validation et un suivi appropriés. Nous allons utiliser la classe `SFTTrainer` de la bibliothèque *Transformers Reinforcement Learning* (TRL), qui est construite au-dessus de la bibliothèque 🤗 *Transformers*. Voici un exemple complet utilisant la bibliothèque TRL :

+

+```python

+from datasets import load_dataset

+from trl import SFTConfig, SFTTrainer

+import torch

+

+# Définir l'appareil

+device = "cuda" if torch.cuda.is_available() else "cpu"

+

+# Charger le jeu de données

+dataset = load_dataset("HuggingFaceTB/smoltalk", "all")

+

+# Configurer les arguments de la classe Trainer

+training_args = SFTConfig(

+ output_dir="./sft_output",

+ max_steps=1000,

+ per_device_train_batch_size=4,

+ learning_rate=5e-5,

+ logging_steps=10,

+ save_steps=100,

+ eval_strategy="steps",

+ eval_steps=50,

+)

+

+# Initialisation de la classe Trainer

+trainer = SFTTrainer(

+ model=model,

+ args=training_args,

+ train_dataset=dataset["train"],

+ eval_dataset=dataset["test"],

+ processing_class=tokenizer,

+)

+

+# Débuter l'entraînement

+trainer.train()

+```

+

+

+Lorsqu'on utilise un jeu de données avec un champ « messages » (comme l'exemple ci-dessus), SFTTrainer applique automatiquement le gabarit de chat du modèle depuis le Hub. Cela signifie que vous n'avez pas besoin de configuration supplémentaire pour gérer les conversations de type chat : la classe Trainer formatera les messages selon le format de gabarits attendu par le modèle.

+

+

+## Empaquetage du jeu de données

+

+SFTTrainer supporte l'empaquetage des exemples afin d'optimiser l'efficacité de l'entraînement. Cette fonctionnalité permet de regrouper plusieurs exemples courts dans la même séquence d'entrée, maximisant ainsi l'utilisation du GPU pendant l'entraînement. Pour activer cette fonctionnalité, il suffit de mettre `packing=True` dans le constructeur SFTConfig. Lorsque vous utilisez des jeux de données avec `max_steps`, soyez conscient que vous pouvez entraîner pendant plus d'époques que prévu en fonction de votre configuration d'empaquetage. Vous pouvez personnaliser la façon dont les exemples sont combinés en utilisant une fonction de formatage. C'est particulièrement utile lorsque vous travaillez avec des jeux de données qui ont plusieurs champs comme les paires question-réponse. Pour les jeux de données d'évaluation, vous pouvez désactiver l'empaquetage en réglant `eval_packing=False` dans SFTConfig. Voici un exemple basique de personnalisation de la configuration d'empaquetage :

+

+```python

+# Configuration

+training_args = SFTConfig(packing=True)

+

+trainer = SFTTrainer(model=model, train_dataset=dataset, args=training_args)

+

+trainer.train()

+```

+

+Lorsque le jeu de données est rempli de plusieurs champs, vous pouvez définir une fonction de formatage personnalisée pour combiner les champs en une seule séquence d'entrée. Cette fonction doit prendre une liste d'exemples et renvoyer un dictionnaire contenant la séquence d'entrée condensée. Voici un exemple de fonction de formatage personnalisée :

+

+```python

+def formatting_func(example):

+ text = f"### Question: {example['question']}\n ### Answer: {example['answer']}"

+ return text

+

+

+training_args = SFTConfig(packing=True)

+trainer = SFTTrainer(

+ "facebook/opt-350m",

+ train_dataset=dataset,

+ args=training_args,

+ formatting_func=formatting_func,

+)

+```

+

+## Suivi des progrès de l'entraînement

+

+Un suivi efficace est essentiel pour un *finetuning* réussi. Voyons ce qu'il faut surveiller pendant l'entraînement :

+

+### Comprendre les schémas de la perte

+

+La fonction de perte de l'entraînement suit généralement trois phases distinctes :

+1. Chute brutale initiale : Adaptation rapide à la nouvelle distribution des données

+2. Stabilisation progressive : Le taux d'apprentissage ralentit au fur et à mesure du *finetuning* du modèle.

+3. Convergence : Les valeurs de la perte se stabilisent, ce qui indique que l'entraînement est terminé.

+

+ +

+### Métriques à surveiller

+

+Un suivi efficace implique le traquage de paramètres quantitatifs et l'évaluation de paramètres qualitatifs. Les mesures disponibles sont les suivantes :

+- Perte d'entraînement

+- Perte de validation

+- Progression du taux d'apprentissage

+- Normes du gradient

+

+

+Soyez attentif à ces signes d'alerte pendant l'entraînement :

+

+### Métriques à surveiller

+

+Un suivi efficace implique le traquage de paramètres quantitatifs et l'évaluation de paramètres qualitatifs. Les mesures disponibles sont les suivantes :

+- Perte d'entraînement

+- Perte de validation

+- Progression du taux d'apprentissage

+- Normes du gradient

+

+

+Soyez attentif à ces signes d'alerte pendant l'entraînement :

+1. La perte de validation augmente alors que la perte d'entraînement diminue (surentraînement)

+2. Pas d'amélioration significative des valeurs de la perte (sousentraînement)

+3. Valeurs de perte extrêmement faibles (mémorisation potentielle)

+4. Formatage incohérent des résultats (problèmes d'apprentissage des gabarits)

+

+

+### Le chemin vers la convergence

+

+Au fur et à mesure que l'entraînement progresse, les courbes des pertes devraientt se stabiliser progressivement. L'indicateur clé d'un entraînement sain est un faible écart entre la perte d'entraînement et la perte de validation, ce qui suggère que le modèle apprend des schémas généralisables plutôt que de mémoriser des exemples spécifiques. Les valeurs de perte absolues varient en fonction de la tâche et de le jeu de données.

+

+### Suivi de la progression de l'entraînement

+

+Le graphique ci-dessus illustre une progression typique de l'entraînement. Remarquez que les pertes d'entraînement et de validation diminuent fortement au début, puis se stabilisent progressivement. Ce schéma indique que le modèle apprend efficacement tout en conservant sa capacité de généralisation.

+

+### Signes d'alerte à surveiller

+

+Plusieurs schémas dans les courbes de perte peuvent indiquer des problèmes potentiels. Nous illustrons ci-dessous les signes d'alerte courants et les solutions que nous pouvons envisager.

+

+ +

+Si la perte de validation diminue à un rythme nettement plus lent que la perte d'entraînement, votre modèle est probablement surentraîné par rapport aux données d'entraînement. Envisagez de :

+- Réduire le nombres d'étapes de l'entraînement

+- Augmenter la taille du jeu de données

+- Valider la qualité et la diversité du jeu de données

+

+

+

+Si la perte de validation diminue à un rythme nettement plus lent que la perte d'entraînement, votre modèle est probablement surentraîné par rapport aux données d'entraînement. Envisagez de :

+- Réduire le nombres d'étapes de l'entraînement

+- Augmenter la taille du jeu de données

+- Valider la qualité et la diversité du jeu de données

+

+ +

+Si la perte ne montre pas d'amélioration significative, le modèle pourrait :

+- Apprendre trop lentement (essayez d'augmenter le taux d'apprentissage)

+- Avoir des difficultés avec la tâche (vérifiez la qualité des données et la complexité de la tâche)

+- Se heurter aux limites de l'architecture (envisager un autre modèle)

+

+

+

+Si la perte ne montre pas d'amélioration significative, le modèle pourrait :

+- Apprendre trop lentement (essayez d'augmenter le taux d'apprentissage)

+- Avoir des difficultés avec la tâche (vérifiez la qualité des données et la complexité de la tâche)

+- Se heurter aux limites de l'architecture (envisager un autre modèle)

+

+ +

+Des valeurs de perte extrêmement faibles peuvent suggérer une mémorisation plutôt qu'un apprentissage. Ceci est particulièrement inquiétant si

+- Le modèle donne des résultats médiocres sur de nouveaux exemples similaires.

+- Les résultats manquent de diversité

+- Les réponses sont trop similaires aux exemples d'entraînement.

+

+

+Surveillez à la fois les valeurs de perte et les sorties réelles du modèle pendant l'entraînement. Parfois, la perte peut sembler bonne alors que le modèle développe des comportements indésirables. Une évaluation qualitative régulière des réponses du modèle permet de déceler des problèmes que les mesures seules pourraient ne pas déceler.

+

+

+Il convient de noter que l'interprétation des valeurs de la perte que nous décrivons ici vise le cas le plus courant, et qu'en fait, elles peuvent se comporter de diverses manières en fonction du modèle, du jeu de données, des paramètres d'entraînement, etc. Si vous souhaitez en savoir plus sur les schémas décrits, nous vous invitons à consulter cet article de blog de l'équipe de [Fast AI](https://www.fast.ai/posts/2023-09-04-learning-jumps/).

+

+## Évaluation après SFT

+

+Dans la section [11.4](/fr/chapter11/4), nous apprendrons à évaluer le modèle à l'aide de jeux de données d'évaluation. Pour l'instant, nous nous concentrerons sur l'évaluation qualitative du modèle.

+

+Après avoir terminé le SFT, envisagez les actions de suivi suivantes :

+1. Évaluer le modèle de manière approfondie sur des données de test conservées.

+2. Valider le respect des gabarits pour les différentes données d'entrée.

+3. Tester la rétention des connaissances spécifiques au domaine

+4. Contrôler les mesures de performance dans le monde réel

+

+

+Documentez votre processus d'entraînement, y compris :

+- Les caractéristiques du jeu de données

+- Les paramètres d'entraînement

+- Les métriques de performance

+- Les limites connues.

+Cette documentation sera précieuse pour les itérations futures du modèle.

+

+

+## Quiz

+

+### 1. Quels sont les paramètres qui déterminent la durée de l'entraînement dans le cadre du SFT ?

+

+

+

+### 2. Quelle schéma dans les courbes de perte indique un surentraînement potentiel ?

+

+

+

+### 3. À quoi sert la fonction gradient_accumulation_steps ?

+

+

+

+### 4. Que faut-il surveiller pendant l'entraînement SFT ?

+

+

+

+### 5. Qu'est-ce qui indique une convergence saine pendant l'entraînement ?

+

+

+

+## 💐 Beau travail !

+

+Vous avez appris à finetuner des modèles à l'aide du SFT ! Pour poursuivre votre apprentissage :

+1. Essayez le *notebook* avec différents paramètres

+2. Expérimentez avec d'autres jeux de données

+3. Contribuer à l'amélioration du matériel de cours

+

+## Additional Resources

+

+- [Documentation de *TRL*](https://huggingface.co/docs/trl)

+- [Répertoire contenant des exemples de SFT](https://github.com/huggingface/trl/blob/main/trl/scripts/sft.py)

+- [Les bonnes pratiques pour le *finetuning*](https://huggingface.co/docs/transformers/training)

diff --git a/chapters/fr/chapter11/4.mdx b/chapters/fr/chapter11/4.mdx

new file mode 100644

index 000000000..19fad9720

--- /dev/null

+++ b/chapters/fr/chapter11/4.mdx

@@ -0,0 +1,173 @@

+

+

+# LoRA (Low-Rank Adaptation)

+

+Le *finetuning* de LLM est un processus gourmand en ressources. LoRA est une technique qui nous permet de finetuner de tels modèles avec un petit nombre de paramètres. Elle fonctionne en ajoutant et en optimisant des matrices plus petites aux poids d'attention, ce qui réduit généralement les paramètres entraînables d'environ 90 %.

+

+## Comprendre la méthode LoRA

+

+LoRA (Low-Rank Adaptation) est une technique de *finetuning* efficace en termes de paramètres qui gèle les poids du modèle pré-entraîné et injecte des matrices de décomposition de rangs entraînables dans les couches du modèle. Au lieu d'entraîner tous les paramètres du modèle pendant le *finetuning*, LoRA décompose les mises à jour des poids en matrices plus petites par le biais d'une décomposition de rang inférieur, réduisaint ainsi considérablement le nombre de paramètres à entraîner tout en maintenant les performances du modèle. Par exemple, lorsqu'il est appliqué au GPT-3 175B, LoRA réduit de 10 000 fois le nombre de paramètres entraînables et de trois fois les besoins en mémoire du par rapport à un *finetuning* complet. Pour en savoir plus sur cette méthode, consultez ce [papier](https://arxiv.org/pdf/2106.09685).

+

+LoRA fonctionne en ajoutant, généralement sur les poids des couches dattention du *transformer*, des paires de matrices de décomposition des rangs. Pendant l'inférence, ces poids d'adaptateur peuvent être fusionnés avec le modèle de base, ce qui n'entraîne aucune latence supplémentaire. LoRA est particulièrement utile pour adapter de grands modèles de langage à des tâches ou domaines spécifiques tout en conservant des besoins en ressources gérables.

+

+## Principaux avantages du LoRA

+

+1. **Efficacité de la mémoire** :

+ - Seuls les paramètres de l`adaptateur sont stockés dans la mémoire du GPU

+ - Les poids du modèle de base restent gelés et peuvent être chargés avec une précision inférieure.

+ - Permet un *finetuning* des grands modèles sur des GPU grand public.

+

+2. **Caractéristiques d'entraînement** :

+ - Intégration native des PEFT/LoRA avec une configuration minimale

+ - Prise en charge de QLoRA (Quantized LoRA) pour une meilleure efficacité de la mémoire.

+

+3. **Gestion des adaptateurs** :

+ - Réduction du poids de l'adaptateur lors des *checkpoints*

+ - Fonctionnalités permettant de fusionner les adaptateurs dans le modèle de base

+

+## Chargement des adaptateurs LoRA avec PEFT

+

+[*PEFT*](https://github.com/huggingface/peft) est une bibliothèque qui fournit une interface unifiée pour charger et gérer les méthodes PEFT (*Parameter-Efficient Fine-Tuning*), y compris LoRA. Elle permet de charger et de passer facilement d'une méthode PEFT à l'autre, ce qui facilite l'expérimentation de différentes techniques de *finetuning*.

+

+Les adaptateurs peuvent être chargés sur un modèle pré-entraîné avec `load_adapter()`, ce qui est utile pour en essayer différents dont les poids ne sont pas fusionnés. Définissez les poids de l'adaptateur actif avec la fonction `set_adapter()`. Pour retourner le modèle de base, vous pouvez utiliser `unload()` pour décharger tous les modules LoRA. Cela facilite le basculement entre différents poids spécifiques à une tâche.

+

+```python

+from peft import PeftModel, PeftConfig

+

+config = PeftConfig.from_pretrained("ybelkada/opt-350m-lora")

+model = AutoModelForCausalLM.from_pretrained(config.base_model_name_or_path)

+lora_model = PeftModel.from_pretrained(model, "ybelkada/opt-350m-lora")

+```

+

+

+

+## Finetuner un LLM en utilisant `trl` et `SFTTrainer` avec LoRA

+

+[SFTTrainer](https://huggingface.co/docs/trl/sft_trainer) de `trl` fournit une intégration avec les adaptateurs LoRA à travers la bibliothèque [PEFT](https://huggingface.co/docs/peft/en/index). Cela signifie que nous pouvons finetuner un modèle de la même manière que nous l'avons fait avec le SFT, mais en utilisant LoRA pour réduire le nombre de paramètres que nous avons besoin d'entraîner.

+

+Nous utiliserons la classe `LoRAConfig` de PEFT dans notre exemple. L'installation ne nécessite que quelques étapes de configuration :

+

+1. Définir la configuration LoRA (rang, alpha, *dropout*).

+2. Créer le SFTTrainer avec la configuration PEFT

+3. Entraîner et sauvegarder les poids de l'adaptateur.

+

+## Configuration du LoRA

+

+Passons en revue la configuration et les paramètres clés du LoRA.

+*** Traduit avec www.DeepL.com/Translator (version gratuite) ***

+

+

+| Paramètres | Description |

+|-----------|-------------|

+| `r` (rank) | Dimension des matrices de rang inférieur utilisées pour la mise à jour des poids. Elle est généralement comprise entre 4 et 32. Des valeurs plus faibles permettent une plus grande compression mais potentiellement moins d'expressivité. |

+| `lora_alpha` | Facteur d'échelle pour les couches LoRA, généralement fixé à deux fois la valeur du rang. Des valeurs plus élevées se traduisent par des effets d'adaptation plus forts. |

+| `lora_dropout` | Probabilité de *dropout* pour les couches LoRA, généralement de 0,05 à 0,1. Des valeurs plus élevées permettent d'éviter un surentraînement pendant l'entraînement. |

+| `bias` | Contrôle l'entraînement des termes de biais. Les options sont « none », « all » ou « lora_only ». L'option « none » est la plus courante pour des raisons d'efficacité de mémoire. |

+| `target_modules` | Spécifie les modules du modèle auxquels appliquer la méthode LoRA. Il peut s'agir de « tous les modules linéaires » ou de modules spécifiques tels que « q_proj, v_proj ». Un plus grand nombre de modules permet une plus grande adaptabilité mais augmente l'utilisation de la mémoire. |

+

+

+Lors de l'implémentation des méthodes PEFT, commencez par de petites valeurs de rang (4-8) pour LoRA et surveillez la perte d'entraînement. Utilisez des ensembles de validation pour éviter le surentraîneùent et comparez les résultats avec des baselines via finetuning complet lorsque cela est possible. L'efficacité des différentes méthodes peut varier en fonction de la tâche, c'est pourquoi l'expérimentation est essentielle.

+

+

+## Utilisation de TRL avec PEFT

+

+Les méthodes PEFT peuvent être combinées avec TRL pour un *finetuning* permettant de réduire les besoins de mémoire. Nous pouvons passer `LoraConfig` au modèle lors de son chargement.

+

+```python

+from peft import LoraConfig

+

+# TODO : Configurer les paramètres de LoRA

+# r : dimension du rang des matrices LoRA (plus petite = plus de compression)

+rank_dimension = 6

+# lora_alpha : facteur d'échelle pour les couches LoRA (plus élevé = adaptation plus forte)

+lora_alpha = 8

+# lora_dropout : probabilité de dropout pour les couches LoRA (aide à prévenir le surentraînement)

+lora_dropout = 0.05

+

+peft_config = LoraConfig(

+ r=rank_dimension, # Dimension du rang, généralement entre 4 et 32

+ lora_alpha=lora_alpha, # Facteur d'échelle LoRA, généralement 2x le rang

+ lora_dropout=lora_dropout, # Probabilité de dropout probability pour les couches de LoRA

+ bias="none", # Type de biais pour le LoRA. Les biais correspondants seront mis à jour pendant l'entraînement

+ target_modules="all-linear", # Modules auxquels appliquer le LoRA

+ task_type="CAUSAL_LM", # Type de tâche pour l'architecture du modèle

+)

+```

+

+Ci-dessus, nous avons utilisé `device_map="auto"` pour assigner automatiquement le modèle au bon appareil. Vous pouvez également assigner manuellement le modèle à un appareil spécifique en utilisant `device_map={"": device_index}`.

+

+Nous aurons également besoin de définir le `SFTTrainer` avec la configuration du LoRA.

+

+```python

+# Créer un SFTTrainer avec la configuration LoRA

+trainer = SFTTrainer(

+ model=model,

+ args=args,

+ train_dataset=dataset["train"],

+ peft_config=peft_config, # Configuration LoRA

+ max_seq_length=max_seq_length, # Longueur maximale de la séquence

+ processing_class=tokenizer,

+)

+```

+

+

+✏️ Essayez ! Reprenez votre modèle de la section précédente, mais finetuné-le avec LoRA. Utilisez le jeu de données `HuggingFaceTB/smoltalk` pour finetuner un modèle `deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B`, en utilisant la configuration LoRA que nous avons définie ci-dessus.

+

+

+## Fusion des adaptateurs LoRA

+

+Après l'entraînement avec LoRA, vous pouvez souhaiter fusionner les poids des adaptateurs dans le modèle de base pour faciliter le déploiement. Cela permet de créer un modèle unique avec les poids combinés, éliminant ainsi la nécessité de charger les adaptateurs séparément pendant l'inférence.

+

+Le processus de fusion nécessite une attention particulière de la gestion de la mémoire et de la précision. Comme vous devrez charger simultanément le modèle de base et les poids des adaptateurs, assurez-vous que la mémoire du GPU/CPU est suffisante. L'utilisation de `device_map="auto"` dans 🤗 *Transformers* trouvera le bon périphérique pour le modèle en fonction de votre matériel.

+

+Maintenez une précision cohérente tout au long du processus, en utilisant la précision utilisée pendant l'entraînement et en sauvegardant le modèle fusionné dans le même format pour le déploiement.

+

+## Mise en œuvre de la fusion

+

+Après l'entraînement d'un adaptateur LoRA, vous pouvez fusionner les poids de l'adaptateur dans le modèle de base. Voici comment procéder :

+

+```python

+import torch

+from transformers import AutoModelForCausalLM

+from peft import PeftModel

+

+# 1. Charger le modèle de basel

+base_model = AutoModelForCausalLM.from_pretrained(

+ "base_model_name", torch_dtype=torch.float16, device_map="auto"

+)

+

+# 2. Charger le modèle PEFT avec l'adaptateur

+peft_model = PeftModel.from_pretrained(

+ base_model, "path/to/adapter", torch_dtype=torch.float16

+)

+

+# 3. Fusionner les poids de l'adaptateur avec le modèle de base

+merged_model = peft_model.merge_and_unload()

+```

+

+Si vous constatez des différences de taille dans le modèle sauvegardé, assurez-vous que vous sauvegardez également le *tokenizer* :

+

+```python

+# Sauvegarde du modèle et du tokenizer

+tokenizer = AutoTokenizer.from_pretrained("base_model_name")

+merged_model.save_pretrained("path/to/save/merged_model")

+tokenizer.save_pretrained("path/to/save/merged_model")

+```

+

+

+✏️ Essayez ! Fusionner les poids de l'adaptateur dans le modèle de base. Utiliser le jeu de données `HuggingFaceTB/smoltalk` pour finetuner un modèle `deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B` grâce à l'approche LoRA que nous avons définie ci-dessus.

+

+

+

+# Ressources

+

+- [Papier de la méthode LoRA (*Low-Rank Adaptation of Large Language Models*)](https://arxiv.org/pdf/2106.09685)

+- [Documentation de la bibliothèque *PEFT*](https://huggingface.co/docs/peft)

+- [Article de blog d'Hugging Face sur *PEFT-](https://huggingface.co/blog/peft)

diff --git a/chapters/fr/chapter11/5.mdx b/chapters/fr/chapter11/5.mdx

new file mode 100644

index 000000000..2917fa0ec

--- /dev/null

+++ b/chapters/fr/chapter11/5.mdx

@@ -0,0 +1,252 @@

+# Évaluation

+

+Avec un modèle finetuné par SFT ou LoRA, nous devrions l'évaluer sur des jeux d'évaluation standards. En tant qu'ingénieurs en apprentissage automatique, vous devez maintenir une série d'évaluations pertinentes pour votre domaine d'intérêt ciblé. Dans cette page, nous examinons certains des jeux d'évaluation les plus courants et la manière de les utiliser pour évaluer votre modèle. Nous verrons également comment créer des jeux d'évaluation personnalisés pour votre cas d'utilisation spécifique.

+

+## Jeux d'évaluation automatiques

+

+Les jeux d'évaluation (*benchmark* en anglais) automatiques servent d'outils standardisés pour l'évaluation des modèles dans différentes tâches et capacités. S'ils constituent un point de départ utile pour comprendre les performances des modèles, il est important de reconnaître qu'ils ne représentent qu'un élément d'une stratégie d'évaluation globale.

+

+## Comprendre les jeux d'évaluation automatiques

+

+Les jeux d'évaluation automatiques consistent généralement en des jeux de données nettoyés avec des tâches et des mesures d'évaluation prédéfinies. Ils visent à évaluer divers aspects de la capacité des modèles, de la compréhension du langage de base au raisonnement complexe. Leur avantage principal est leur standardisation, permettant une comparaison cohérente entre différents modèles et permettent d'obtenir des résultats reproductibles.

+

+Toutefois, il est essentiel de comprendre que les performances des jeux d'évaluation ne se traduisent pas toujours directement par une efficacité dans le monde réel. Un modèle qui excelle sur des jeux académiques peut encore éprouver des difficultés avec des applications de domaines spécifiques ou des cas d'utilisation pratiques.

+

+## Jeux d'évaluation de connaissances générales

+

+[MMLU](https://huggingface.co/datasets/cais/mmlu) (*Massive Multitask Language Understanding*) permet de tester les connaissances d'un modèle dans 57 matières, des sciences aux sciences humaines. Bien qu'il soit complet, il peut ne pas refléter la profondeur de l'expertise nécessaire pour des domaines spécifiques. TruthfulQA évalue la tendance d'un modèle à reproduire les idées fausses les plus courantes, bien qu'il ne puisse pas saisir toutes les formes de désinformation.

+

+## Jeux d'évaluation du raisonnement

+

+[BBH](https://huggingface.co/datasets/lukaemon/bbh) (*Big Bench Hard*) et [GSM8K](https://huggingface.co/datasets/openai/gsm8k) se concentrent sur des tâches de raisonnement complexes. BBH teste la pensée logique et la planification, tandis que le GSM8K cible spécifiquement la résolution de problèmes mathématiques. Ces jeux d'évaluation permettent d'évaluer les capacités d'analyse, mais peuvent ne pas rendre compte du raisonnement nuancé requis dans les scénarios du monde réel.

+

+## Compréhension du langage

+

+[HELM](https://github.com/stanford-crfm/helm) fournit un cadre d'évaluation holistique. Les jeux d'évaluation comme HELM donnent un aperçu des capacités de traitement du langage sur des aspects tels que le bon sens, la connaissance du monde et le raisonnement. Mais ils peuvent ne pas représenter pleinement la complexité d'une conversation naturelle ou d'une terminologie spécifique à un domaine.

+

+## Jeux d'évaluation spécifiques à un domaine

+

+Examinons quelques jeux d'évaluation axés sur des domaines spécifiques tels que les mathématiques, le codage et le chat.

+

+Le [MATH](https://huggingface.co/papers/2103.03874) est un autre outil d'évaluation important pour le raisonnement mathématique. Il se compose de 12 500 problèmes issus de concours de mathématiques, couvrant l'algèbre, la géométrie, la théorie des nombres, le comptage, les probabilités, etc. Ce qui rend MATH particulièrement difficile, c'est qu'il exige un raisonnement en plusieurs étapes, la compréhension de la notation mathématique formelle et la capacité à générer des solutions étape par étape. Contrairement aux tâches arithmétiques plus simples, les problèmes de MATH exigent souvent des stratégies de résolution de problèmes sophistiquées et l'application de concepts mathématiques.

+

+[HumanEval](https://github.com/openai/human-eval) est un jeu de données d'évaluation axé sur le codage et composé de 164 problèmes de programmation. Il teste la capacité d'un modèle à générer un code Python fonctionnellement correct qui résout les tâches de programmation données. Ce qui rend HumanEval particulièrement précieux, c'est qu'il évalue à la fois les capacités de génération de code et la correction fonctionnelle par le biais de l'exécution de cas de test réels, plutôt que par une simple similitude superficielle avec des solutions de référence. Les problèmes vont de la simple manipulation de chaînes de caractères à des algorithmes et des structures de données plus complexes.

+

+[Alpaca Eval](https://tatsu-lab.github.io/alpaca_eval/) est un cadre d'évaluation automatisé conçu pour évaluer la qualité des modèles de langage à suivre des instructions. Il utilise GPT-4 comme juge pour évaluer les résultats du modèle selon diverses dimensions, notamment l'utilité, l'honnêteté et l'innocuité. Le cadre comprend un jeu de données de 805 d'instructions soigneusement sélectionnées et peut évaluer les réponses par rapport à plusieurs modèles de référence tels que Claude, GPT-4 et d'autres. Ce qui rend Alpaca Eval particulièrement utile, c'est sa capacité à fournir des évaluations cohérentes et évolutives sans nécessiter d'annotateurs humains, tout en capturant des aspects nuancés de la performance du modèle que les mesures traditionnelles pourraient manquer.

+

+## Autres méthodes d'évaluation

+

+De nombreuses organisations ont développé des méthodes d'évaluation alternatives pour répondre aux limites des jeux d'évaluation standards :

+

+### *LLM-as-Judge*

+

+L'utilisation d'un modèle de langage pour évaluer les résultats d'un autre modèle est de plus en plus populaire. Cette approche peut fournir un retour d'information plus nuancé que les mesures traditionnelles, bien qu'elle s'accompagne de ses propres biais et limites.

+

+### Arènes d'évaluation

+

+Les arènes d'évaluation telles que [Chatbot Arena](https://lmarena.ai/) offrent une approche unique pour évaluer les LLM via des retours humains massifs. Sur ces plateformes, les utilisateurs s'engagent dans des « batailles » anonymes entre deux LLM, en posant des questions et en votant pour le modèle qui fournit les meilleures réponses. Cette approche permet de saisir les modes d'utilisation et les préférences du monde réel grâce à des questions variées et stimulantes, et les études montrent une forte concordance entre les votes de la foule et les évaluations d'experts. Bien que puissantes, ces plateformes présentent des limites, notamment un biais potentiel de la base d'utilisateurs, des distributions d'instructions biaisées et un accent mis sur l'utilité plutôt que sur les considérations de sécurité.

+

+### Jeux d'évaluation personnalisés

+

+Les organisations développent souvent des suites d'évaluations internes adaptées à leurs besoins spécifiques et à leurs cas d'utilisation. Il peut s'agir de tests de connaissances spécifiques à un domaine ou de scénarios d'évaluation qui reflètent les conditions réelles de déploiement.

+

+## Évaluation personnalisée

+

+Si les jeux d'évaluation standards constituent une base de référence utile, ils ne doivent pas être votre seule méthode d'évaluation. Voici comment développer une approche plus complète :

+

+1. Commencez par des jeux d'évaluation standards pertinents pour établir une base de référence et permettre la comparaison avec d'autres modèles.

+

+2. Identifiez les exigences et les défis spécifiques de votre cas d'utilisation. Quelles tâches votre modèle va-t-il réellement accomplir ? Quels types d'erreurs seraient les plus problématiques ?

+

+3. Développez des jeux de données d'évaluation personnalisés qui reflètent votre cas d'utilisation réel. Cela pourrait inclure :

+ - Des requêtes d'utilisateurs réels provenant de votre domaine

+ - Des cas de figure courants que vous avez rencontrés

+ - Des exemples de scénarios particulièrement difficiles.

+

+4. Envisagez de mettre en œuvre une stratégie d'évaluation à plusieurs niveaux :

+ - Mesures automatisées pour un retour d'information rapide

+ - Évaluation humaine pour une compréhension nuancée

+ - Examen par des experts du domaine pour les applications spécialisées

+ - Tests A/B dans des environnements contrôlés

+

+## Implémentation d'évaluations personnalisées

+

+Dans cette section, nous allons implémenter l'évaluation de notre modèle finetuné. Nous pouvons utiliser [`lighteval`](https://github.com/huggingface/lighteval) pour évaluer notre modèle sur des jeux d'évaluation standards, car contient une large gamme de tâches intégrées dans la bibliothèque. Il suffit de définir les tâches que nous voulons évaluer et les paramètres de l'évaluation.

+

+Les tâches de LightEval sont définies selon un format spécifique :

+

+```

+{suite}|{task}|{num_few_shot}|{auto_reduce}

+```

+

+| Paramètres | Description |

+|-----------|-------------|

+| `suite` | La suite de jeux d'évaluation (ex : 'mmlu', 'truthfulqa') |

+| `task` | Tâche spécifique au sein de la suite (ex : 'abstract_algebra') |

+| `num_few_shot` | Nombre d'exemples à inclure dans l'instruction |

+| `auto_reduce` | Possibilité de réduire automatiquement les exemples si l'instruction est trop longue (0 ou 1) |

+

+Exemple : `"mmlu|abstract_algebra|0|0"` évalue le modèle sur la tâche d'algèbre abstraite de MMLU via une inférence avec zéro exemple.

+

+## Exemple de pipeline d'évaluation

+

+Mettons en place un pipeline d'évaluation pour notre modèle finetuné. Nous évaluerons le modèle sur un ensemble de sous-tâches liées au domaine de la médecine.

+

+Voici un exemple complet d'évaluation sur des jeux d'évaluation automatiques relatifs à un domaine spécifique en utilisant Lighteval avec le *backend* VLLM :

+

+```bash

+lighteval accelerate \

+ "pretrained=your-model-name" \

+ "mmlu|anatomy|0|0" \

+ "mmlu|high_school_biology|0|0" \

+ "mmlu|high_school_chemistry|0|0" \

+ "mmlu|professional_medicine|0|0" \

+ --max_samples 40 \

+ --batch_size 1 \

+ --output_path "./results" \

+ --save_generations true

+```

+

+Les résultats sont affichés sous forme de tableau :

+

+```

+| Task |Version|Metric|Value | |Stderr|

+|----------------------------------------|------:|------|-----:|---|-----:|

+|all | |acc |0.3333|± |0.1169|

+|leaderboard:mmlu:_average:5 | |acc |0.3400|± |0.1121|

+|leaderboard:mmlu:anatomy:5 | 0|acc |0.4500|± |0.1141|

+|leaderboard:mmlu:high_school_biology:5 | 0|acc |0.1500|± |0.0819|

+```

+

+Lighteval inclut également une API python pour des tâches d'évaluation plus détaillées, ce qui est utile pour manipuler les résultats d'une manière plus flexible. Consultez la [documentation de Lighteval](https://huggingface.co/docs/lighteval/using-the-python-api) pour plus d'informations.

+

+

+✏️ Essayez ! Évaluez votre modèle finetuné sur une tâche spécifique de lighteval.

+

+

+# Quiz de fin de chapitre

+

+

+

+### 1. Quels sont les principaux avantages de l'utilisation de jeux d'évaluation automatiques pour l'évaluation des modèles ?

+

+

+

+### 2. Quel jeu d'évaluation teste les connaissances dans 57 matières différentes ??

+

+

+

+### 3. Qu'est-ce qu'un LLM-as-Judge ?

+

+

+

+### 4. Quels sont les éléments à inclure dans une stratégie d'évaluation globale ?

+

+

+

+### 5. Qu'est-ce qu'une limitation des jeux d'évaluation automatiques ?

+

+

+

+### 6. Quel est l'objectif de la création de jeux de données d'évaluation personnalisés ?

+

+

diff --git a/chapters/fr/chapter11/6.mdx b/chapters/fr/chapter11/6.mdx

new file mode 100644

index 000000000..d3022a2a1

--- /dev/null

+++ b/chapters/fr/chapter11/6.mdx

@@ -0,0 +1,13 @@

+# Conclusion

+

+Dans ce chapitre, nous avons exploré les composantes essentielles du *finetuning* des modèles de langage :

+

+1. Les **Gabarits de chat** structurent les interactions du modèle, garantissant des réponses cohérentes et appropriées grâce à une mise en forme standardisée.

+

+2. Le ***Finetuning* Supervisé (SFT)** permet d'adapter les modèles pré-entraînés à des tâches spécifiques tout en conservant leurs connaissances fondamentales.

+

+3. **LoRA** offre une approche efficace du *finetuning* en réduisant les paramètres entraînables tout en préservant les performances du modèle.

+

+4. **L'évaluation** permet de mesurer et de valider l'efficacité du *finetuning* à l'aide de diverses mesures et références.

+

+Ces techniques, lorsqu'elles sont combinées, permettent la création de modèles spécialisés qui peuvent exceller dans des tâches spécifiques tout en restant efficaces en termes de calcul. Que vous construisiez un robot de service à la clientèle ou un assistant spécifique à un domaine, la compréhension de ces concepts est cruciale pour une adaptation réussie du modèle.

\ No newline at end of file

diff --git a/chapters/fr/chapter11/7.mdx b/chapters/fr/chapter11/7.mdx

new file mode 100644

index 000000000..e5faf6998

--- /dev/null

+++ b/chapters/fr/chapter11/7.mdx

@@ -0,0 +1,30 @@

+# C'est l'heure de l'examen !

+

+Il est temps de mettre vos connaissances à l'épreuve ! Nous avons préparé un petit questionnaire pour tester votre compréhension des concepts abordés dans ce chapitre.

+

+Pour répondre à ce questionnaire, vous devez suivre les étapes suivantes :

+

+1. Connectez-vous à votre compte Hugging Face.

+2. Répondez aux questions du questionnaire.

+3. Envoyez vos réponses.

+

+## Quiz à choix multiples

+

+Dans ce quiz, il vous sera demandé de sélectionner la bonne réponse à partir d'une liste d'options. Nous allons vous tester sur les principes fondamentaux du *finetuning* supervisé.

+

+

+

+## Quiz sur le code

+

+Dans ce quiz, il vous sera demandé d'écrire du code pour accomplir une tâche. Nous vous testerons sur le code que vous avez étudié dans le cours à partir de bibliothèques comme `datasets`, `transformers`, `peft`, et `TRL`.

+

\ No newline at end of file

diff --git a/chapters/fr/chapter7/5.mdx b/chapters/fr/chapter7/5.mdx

index 0a963e8cb..3b997d136 100644

--- a/chapters/fr/chapter7/5.mdx

+++ b/chapters/fr/chapter7/5.mdx

@@ -589,7 +589,7 @@ def compute_metrics(eval_pred):

Ensuite, nous devons définir un assembleur de données pour notre tâche de séquence à séquence. Comme mT5 est un *transformer* encodeur-décodeur, une des subtilités de la préparation de nos batchs est que, pendant le décodage, nous devons décaler les étiquettes d'une unité vers la droite. Ceci est nécessaire pour garantir que le décodeur ne voit que les étiquettes de vérité terrain précédentes et non les étiquettes actuelles ou futures, qui seraient faciles à mémoriser pour le modèle. Cela ressemble à la façon dont l'auto-attention masquée est appliquée aux entrées dans une tâche comme [la modélisation causale du langage](/course/fr/chapter7/6).

-Heureusement, 🤗 *Transformers* fournit un assembleur `DataCollatorForSeq2Seq` qui rembourrera dynamiquement les entrées et les étiquettes pour nous. Pour instancier ce assembleur, nous devons simplement fournir le *tokenizer* et le *modèle* :

+Heureusement, 🤗 *Transformers* fournit un assembleur `DataCollatorForSeq2Seq` qui rembourrera dynamiquement les entrées et les étiquettes pour nous. Pour instancier cet assembleur, nous devons simplement fournir le *tokenizer* et le *modèle* :

{#if fw === 'pt'}

@@ -609,7 +609,7 @@ data_collator = DataCollatorForSeq2Seq(tokenizer, model=model, return_tensors="t

{/if}

-Voyons ce que produit ce assembleur lorsqu'on lui donne un petit batch d'exemples. Tout d'abord, nous devons supprimer les colonnes contenant des chaînes de caractères, car le assembleur ne saura pas comment remplir ces éléments :

+Voyons ce que produit cet assembleur lorsqu'on lui donne un petit batch d'exemples. Tout d'abord, nous devons supprimer les colonnes contenant des chaînes de caractères, car l'assembleur ne saura pas comment remplir ces éléments :

```python

tokenized_datasets = tokenized_datasets.remove_columns(

@@ -617,7 +617,7 @@ tokenized_datasets = tokenized_datasets.remove_columns(

)

```

-Comme le assembleur attend une liste de `dict`, où chaque `dict` représente un seul exemple du jeu de données, nous devons également mettre les données dans le format attendu avant de les transmettre au assembleur de données :

+Comme l'assembleur attend une liste de `dict`, où chaque `dict` représente un seul exemple du jeu de données, nous devons également mettre les données dans le format attendu avant de les transmettre à l'assembleur de données :

```python

features = [tokenized_datasets["train"][i] for i in range(2)]

@@ -700,7 +700,7 @@ Pour conclure cette section, voyons comment nous pouvons également *finetuner*

{:else}

-Nous sommes presque prêts à nous entraîner ! Nous devons juste convertir nos jeux de données en `tf.data.Dataset` en utilisant le assembleur de données que nous avons défini ci-dessus, puis utiliser `compile()` et `fit()`. D'abord, les jeux de données :

+Nous sommes presque prêts à nous entraîner ! Nous devons juste convertir nos jeux de données en `tf.data.Dataset` en utilisant l'assembleur de données que nous avons défini ci-dessus, puis utiliser `compile()` et `fit()`. D'abord, les jeux de données :

```python

tf_train_dataset = model.prepare_tf_dataset(

@@ -835,7 +835,7 @@ Maintenant que nous avons des jeux de données constitués uniquement de tenseur

model = AutoModelForSeq2SeqLM.from_pretrained(model_checkpoint)

```

-Nous pouvons ensuite instancier le assembleur de données et l'utiliser pour définir nos chargeurs de données :

+Nous pouvons ensuite instancier l'assembleur de données et l'utiliser pour définir nos chargeurs de données :

```python

from torch.utils.data import DataLoader

diff --git a/chapters/fr/chapter7/6.mdx b/chapters/fr/chapter7/6.mdx

index 91c90a96c..2529d3bc8 100644

--- a/chapters/fr/chapter7/6.mdx

+++ b/chapters/fr/chapter7/6.mdx

@@ -324,7 +324,7 @@ _________________________________________________________________

{/if}

-Notre modèle comporte 124 millions de paramètres que nous devrons régler. Avant de commencer l'entraînement, nous devons configurer un assembleur de données qui se chargera de créer les batchs. Nous pouvons utiliser le assembleur `DataCollatorForLanguageModeling`, qui est conçu spécifiquement pour la modélisation du langage (comme son nom le suggère subtilement). En plus de l'empilage et du rembourrage des batchs, il s'occupe aussi de la création des étiquettes du modèle de langage. Dans la modélisation causale du langage, les entrées servent aussi d'étiquettes (juste décalées d'un élément) et que le assembleur de données crée à la volée pendant l'entraînement pour ne pas avoir à dupliquer les `input_ids`.

+Notre modèle comporte 124 millions de paramètres que nous devrons régler. Avant de commencer l'entraînement, nous devons configurer un assembleur de données qui se chargera de créer les batchs. Nous pouvons utiliser l'assembleur `DataCollatorForLanguageModeling`, qui est conçu spécifiquement pour la modélisation du langage (comme son nom le suggère subtilement). En plus de l'empilage et du rembourrage des batchs, il s'occupe aussi de la création des étiquettes du modèle de langage. Dans la modélisation causale du langage, les entrées servent aussi d'étiquettes (juste décalées d'un élément) et que l'assembleur de données crée à la volée pendant l'entraînement pour ne pas avoir à dupliquer les `input_ids`.

Notez que `DataCollatorForLanguageModeling` supporte à la fois la modélisation du langage masqué (MLM pour *masked language modeling*) et la modélisation du langage causal (CLM pour *causal language modeling*). Par défaut, il prépare les données pour la MLM mais nous pouvons passer à la CLM en définissant l'argument `mlm=False` :

diff --git a/chapters/fr/chapter9/1.mdx b/chapters/fr/chapter9/1.mdx

index 8dd18331c..7c89fdc75 100644

--- a/chapters/fr/chapter9/1.mdx

+++ b/chapters/fr/chapter9/1.mdx

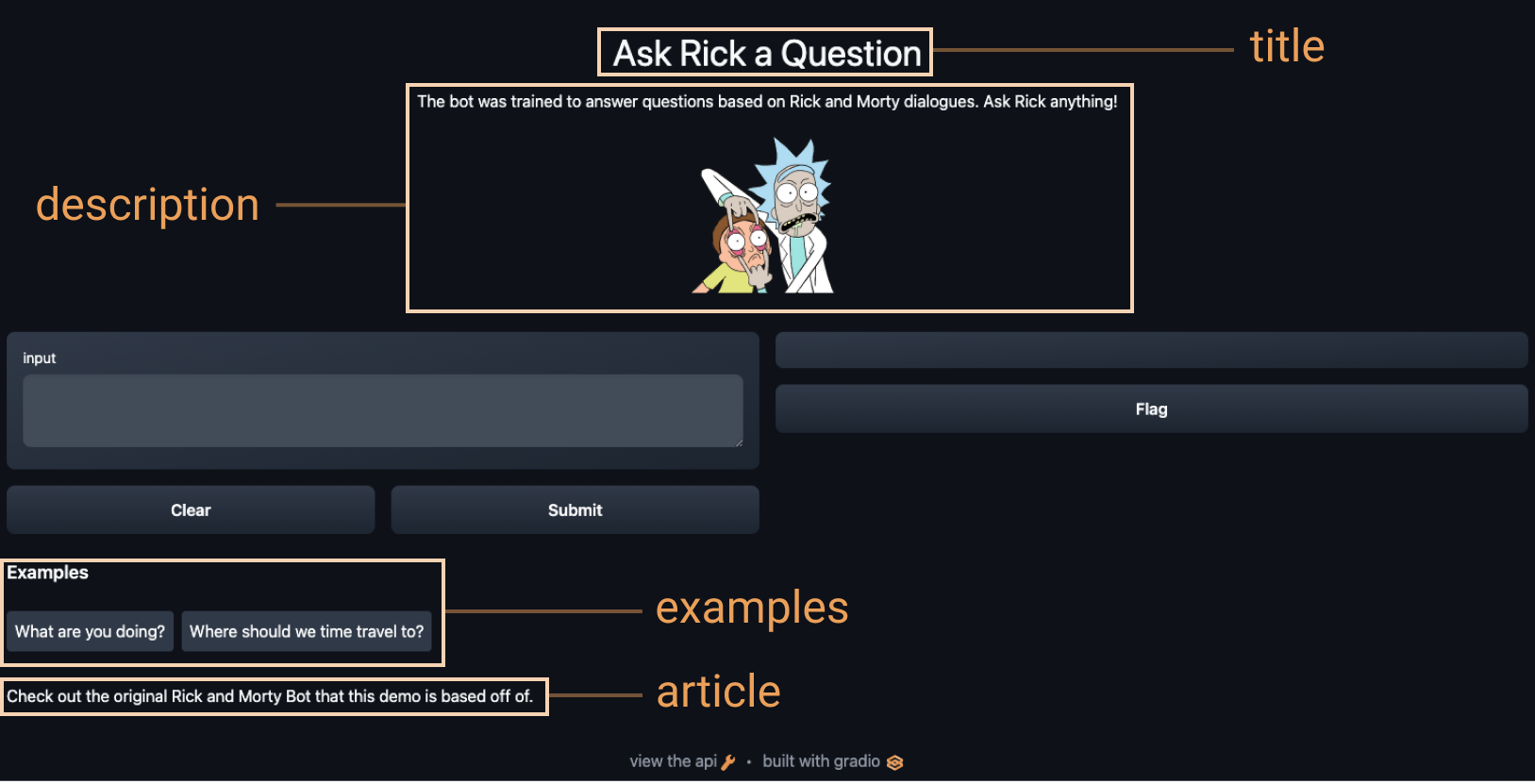

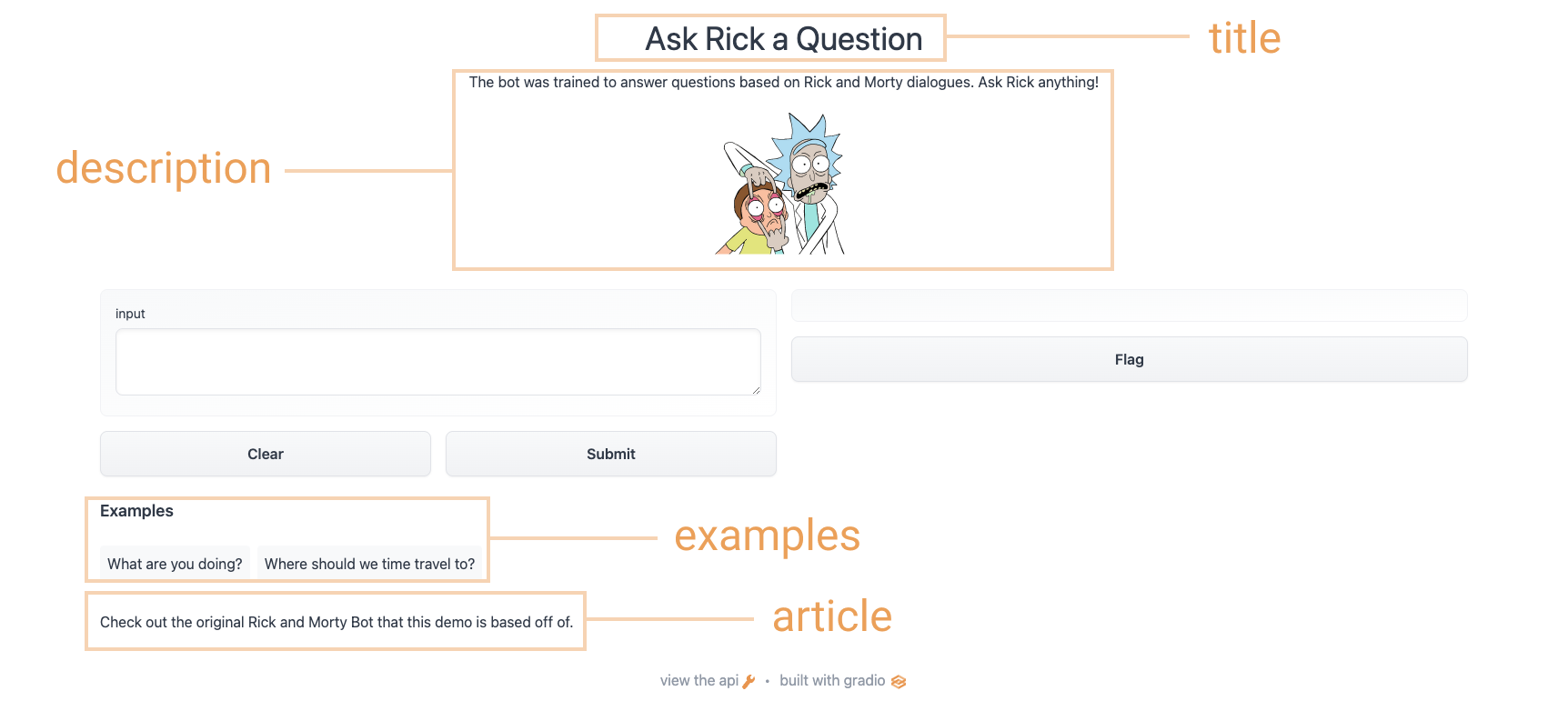

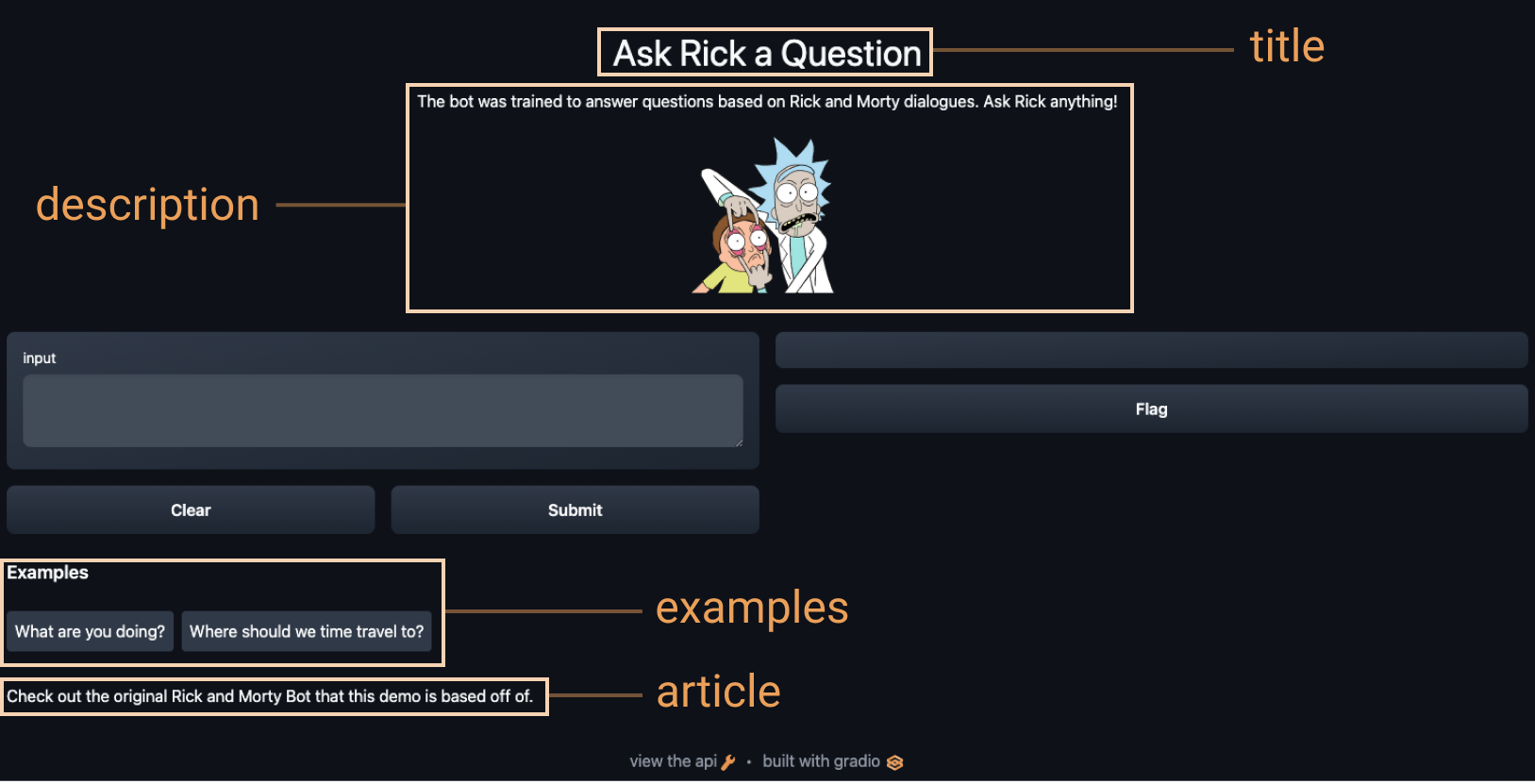

@@ -1,37 +1,37 @@

-# Introduction à Gradio

-

-

-

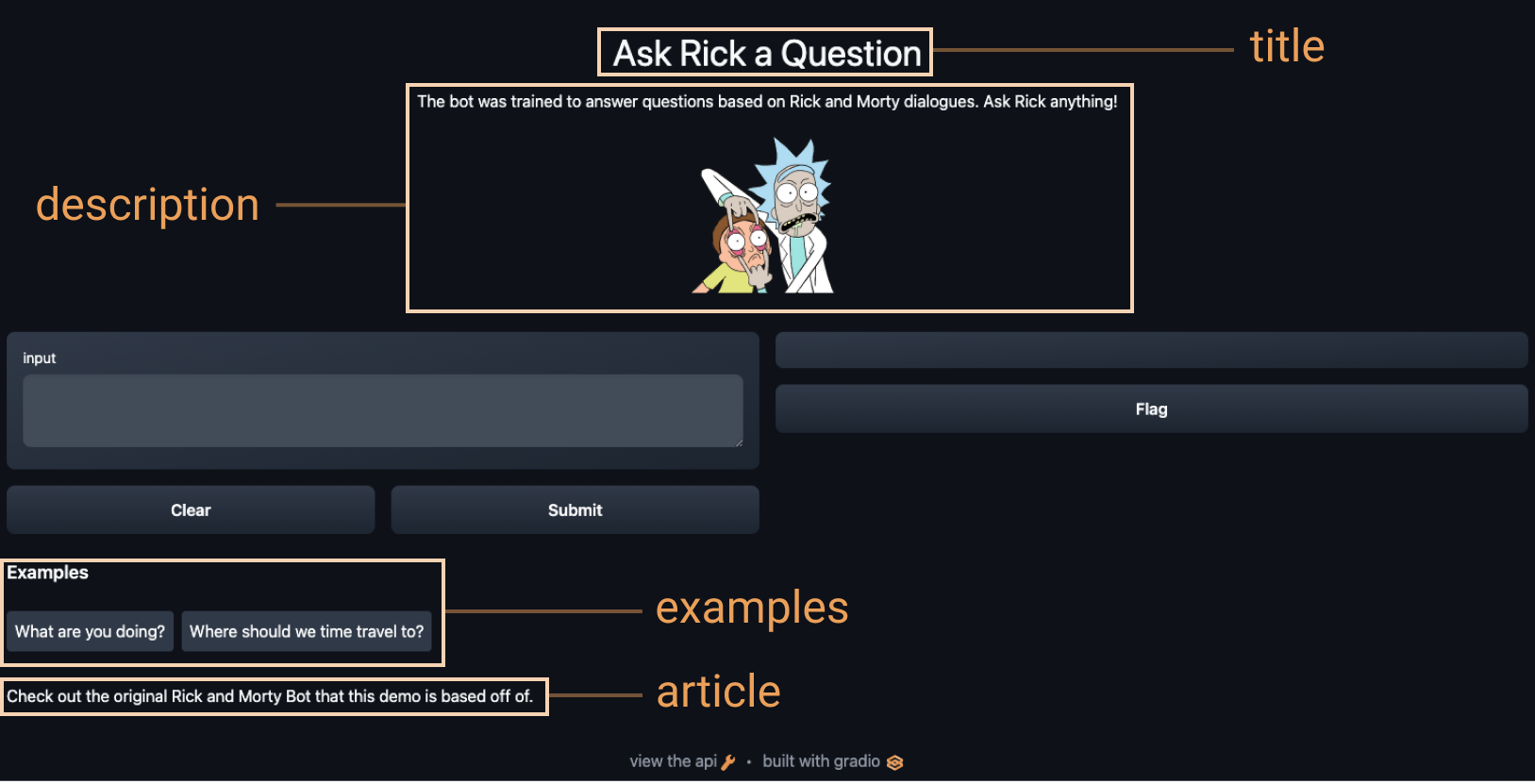

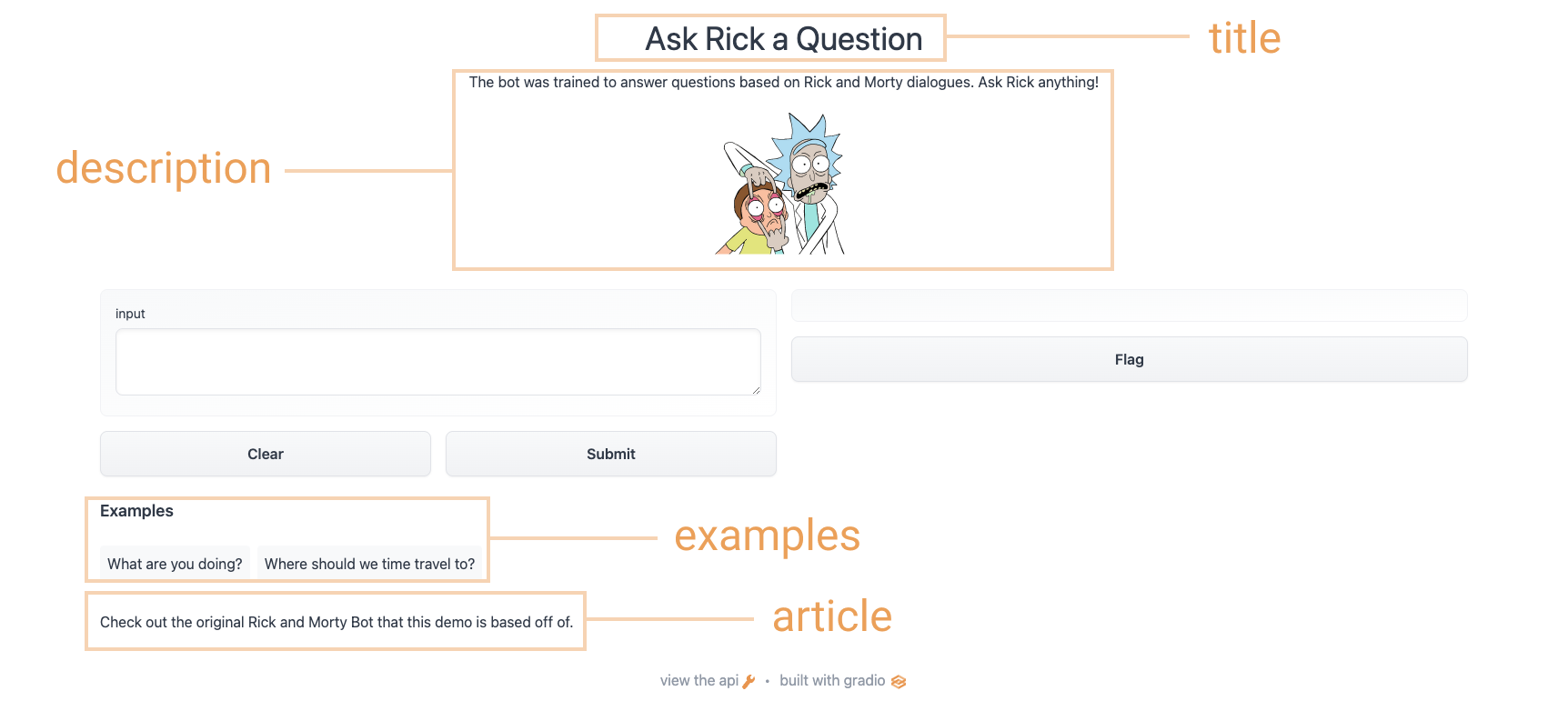

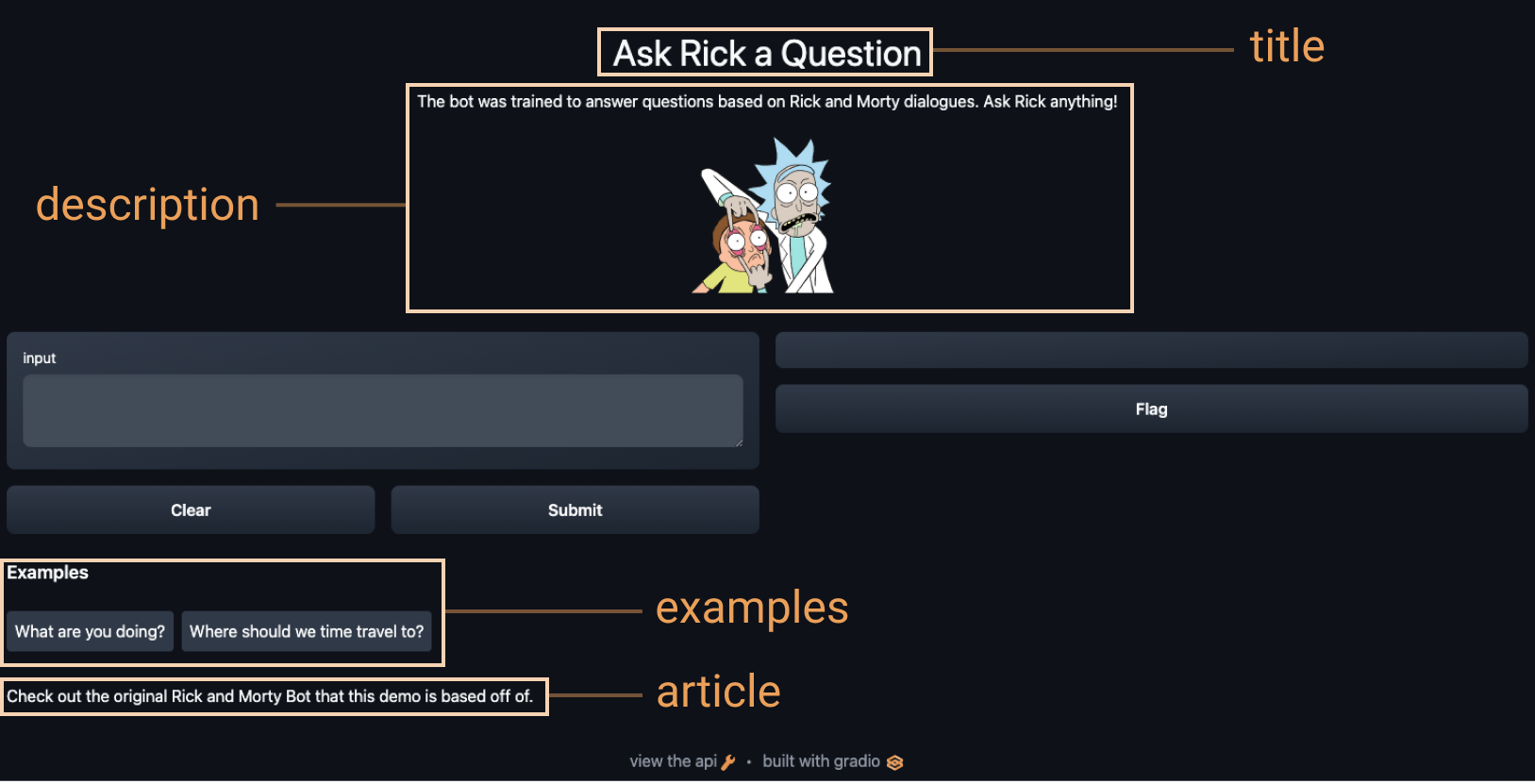

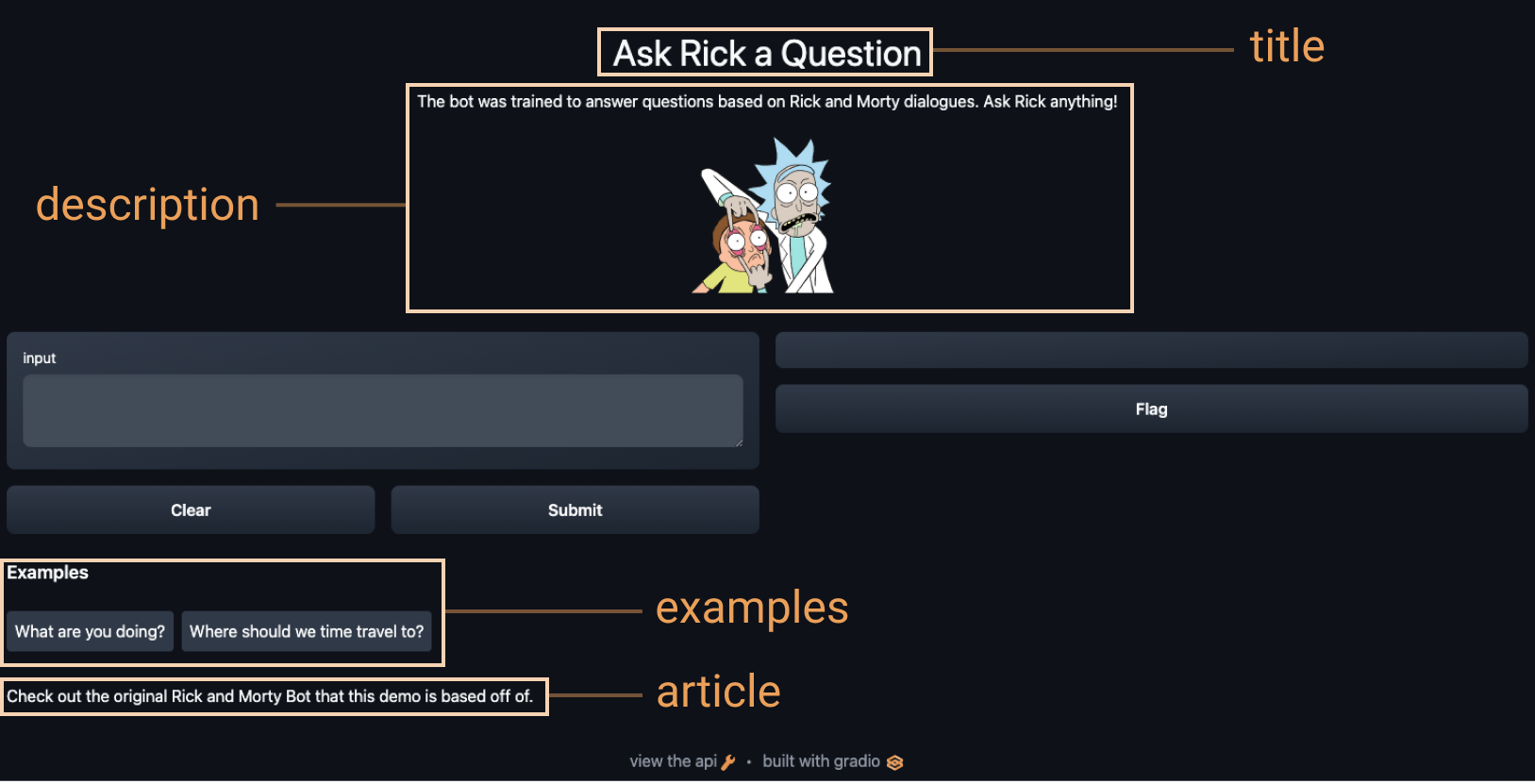

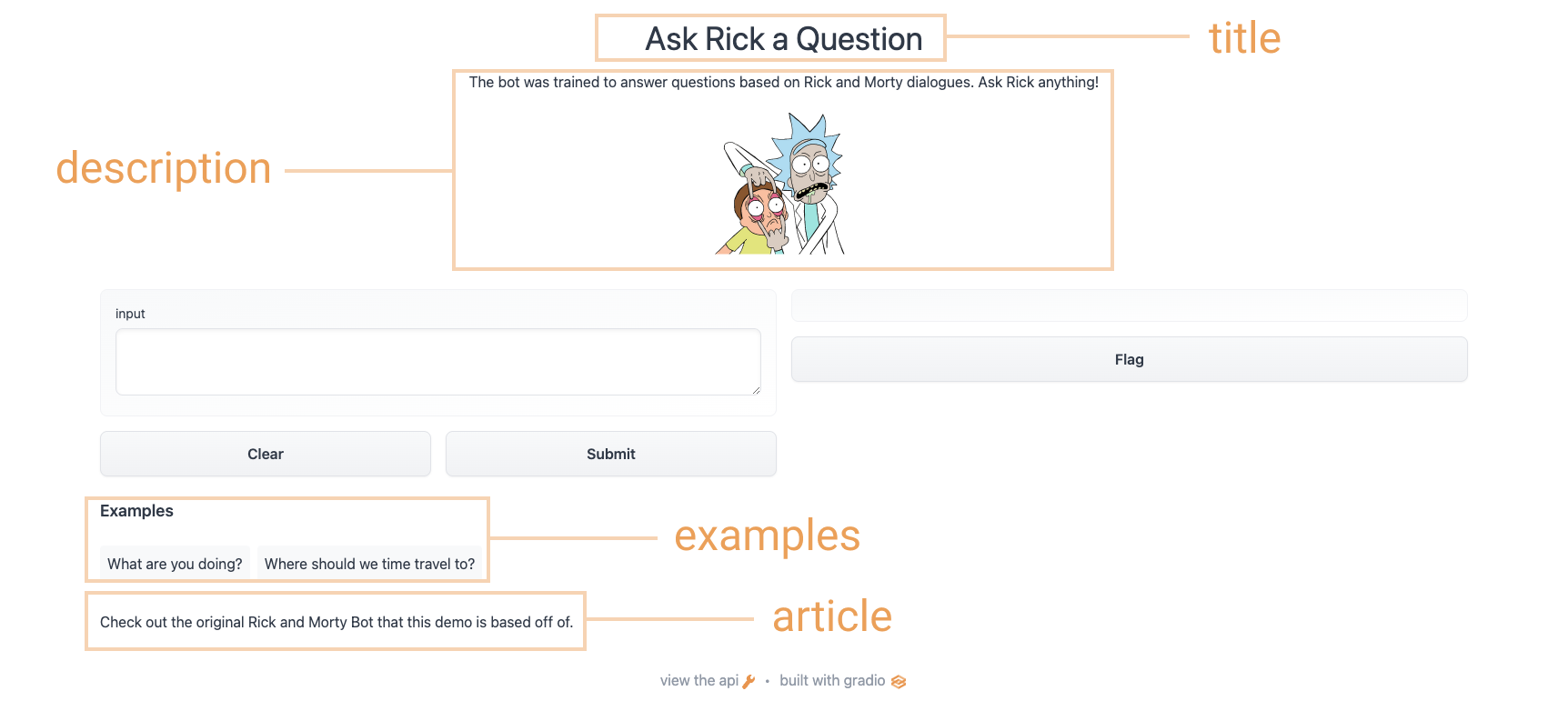

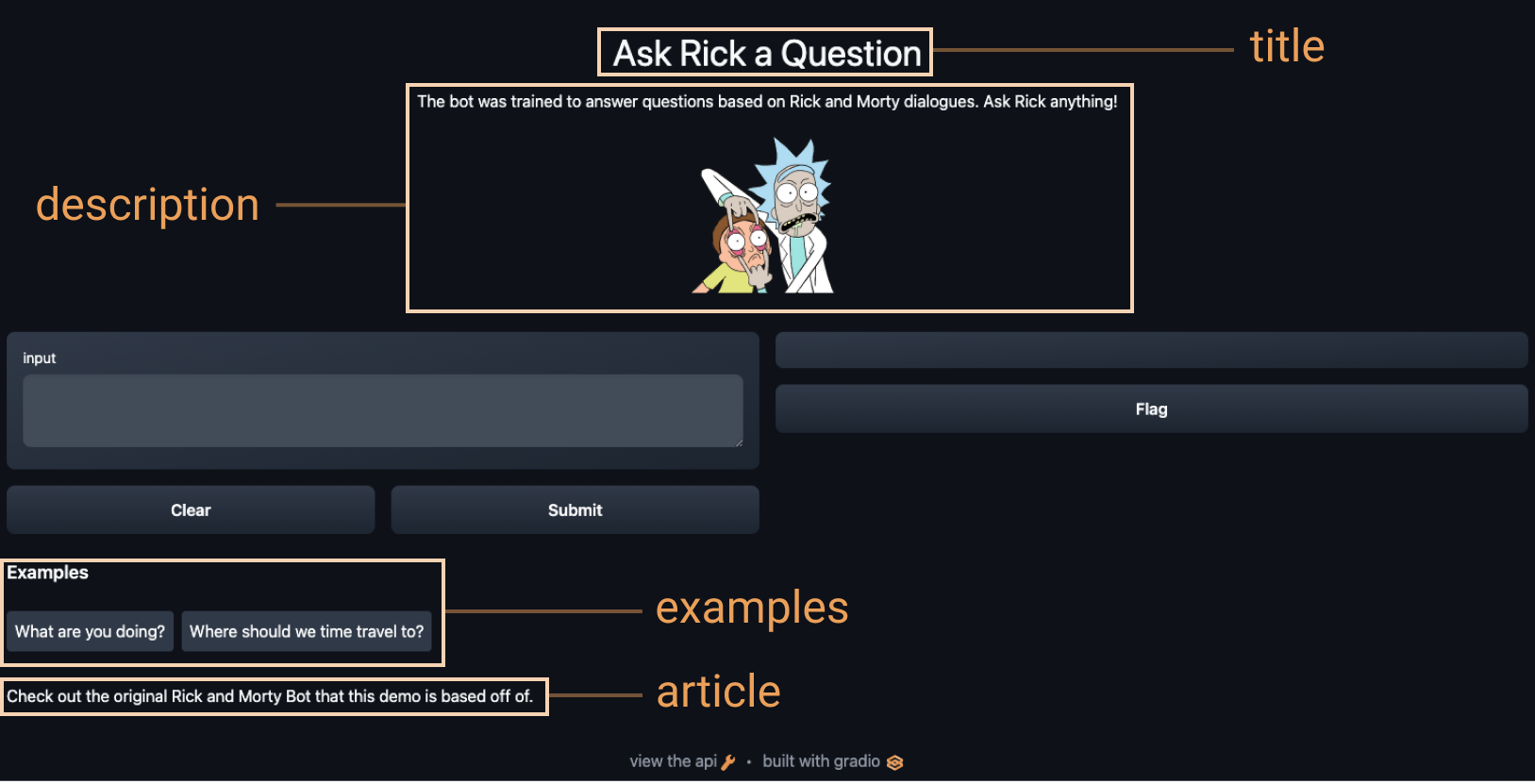

-Dans ce chapitre, nous allons apprendre à construire des **démos interactives** pour vos modèles d'apprentissage automatique.

-

-Pourquoi construire une démo ou une interface graphique pour votre modèle d'apprentissage automatique ? Les démos permettent :

-

-- aux **développeurs en apprentissage automatique** de présenter facilement leur travail à un large public, y compris des équipes non techniques ou des clients.

-- aux **chercheurs** de reproduire plus facilement les modèles d'apprentissage automatique et leur comportement.

-- aux **testeurs qualité** ou **utilisateurs finaux** d'identifier et de déboguer plus facilement les points de défaillance des modèles.

-- aux **utilisateurs divers** de découvrir les biais algorithmiques des modèles.

-

-Nous utiliserons la bibliothèque *Gradio* pour construire des démos pour nos modèles. *Gradio* vous permet de construire, de personnaliser et de partager des démos en ligne pour n'importe quel modèle d'apprentissage automatique. Et cela entièrement en Python.

-

-Voici quelques exemples de démos d'apprentissage automatique construites avec Gradio :

-

-* Un modèle de **reconnaissance de croquis** qui prend un croquis et produit des étiquettes de ce qu'il pense être dessiné :

-

-

-

-* Un modèle extractif de **réponse à une question** qui prend en entrée un paragraphe de contexte et une requête et produit une réponse et un score de probabilité (nous avons discuté de ce type de modèle [au chapitre 7](/course/fr/chapter7/7)) :

-

-

-

-* Un modèle de **suppression de l'arrière-plan** qui prend une image et la restitue avec l'arrière-plan supprimé :

-

-

-

-Ce chapitre est divisé en sections qui comprennent à la fois des _concepts_ et des _applications_. Après avoir appris le concept dans chaque section, vous l'appliquerez pour construire un type particulier de démo, allant de la classification d'images à la reconnaissance vocale. À la fin de ce chapitre, vous serez en mesure de créer ces démos (et bien d'autres !) en quelques lignes de code Python seulement.

-

-

-👀 Consultez Hugging Face Spaces pour voir de nombreux exemples récents de démos d'apprentissage automatique construites par la communauté !

-

+# Introduction à Gradio

+

+

+

+Dans ce chapitre, nous allons apprendre à construire des **démos interactives** pour vos modèles d'apprentissage automatique.

+

+Pourquoi construire une démo ou une interface graphique pour votre modèle d'apprentissage automatique ? Les démos permettent :

+

+- aux **développeurs en apprentissage automatique** de présenter facilement leur travail à un large public, y compris des équipes non techniques ou des clients.

+- aux **chercheurs** de reproduire plus facilement les modèles d'apprentissage automatique et leur comportement.

+- aux **testeurs qualité** ou **utilisateurs finaux** d'identifier et de déboguer plus facilement les points de défaillance des modèles.

+- aux **utilisateurs divers** de découvrir les biais algorithmiques des modèles.

+

+Nous utiliserons la bibliothèque *Gradio* pour construire des démos pour nos modèles. *Gradio* vous permet de construire, de personnaliser et de partager des démos en ligne pour n'importe quel modèle d'apprentissage automatique. Et cela entièrement en Python.

+

+Voici quelques exemples de démos d'apprentissage automatique construites avec Gradio :

+

+* Un modèle de **reconnaissance de croquis** qui prend un croquis et produit des étiquettes de ce qu'il pense être dessiné :

+

+

+

+* Un modèle extractif de **réponse à une question** qui prend en entrée un paragraphe de contexte et une requête et produit une réponse et un score de probabilité (nous avons discuté de ce type de modèle [au chapitre 7](/course/fr/chapter7/7)) :

+

+

+

+* Un modèle de **suppression de l'arrière-plan** qui prend une image et la restitue avec l'arrière-plan supprimé :

+

+

+

+Ce chapitre est divisé en sections qui comprennent à la fois des _concepts_ et des _applications_. Après avoir appris le concept dans chaque section, vous l'appliquerez pour construire un type particulier de démo, allant de la classification d'images à la reconnaissance vocale. À la fin de ce chapitre, vous serez en mesure de créer ces démos (et bien d'autres !) en quelques lignes de code Python seulement.

+

+

+👀 Consultez Hugging Face Spaces pour voir de nombreux exemples récents de démos d'apprentissage automatique construites par la communauté !

+

diff --git a/chapters/fr/chapter9/2.mdx b/chapters/fr/chapter9/2.mdx

index 8d2ba3e71..dca028ea1 100644

--- a/chapters/fr/chapter9/2.mdx

+++ b/chapters/fr/chapter9/2.mdx

@@ -1,119 +1,119 @@

-# Construire votre première démo

-

-

-

-Commençons par installer *Gradio* ! Comme il s'agit d'un *package* Python, il suffit de l'exécuter :

-

-`$ pip install gradio `

-

-Vous pouvez exécuter *Gradio* n'importe où, que ce soit dans votre IDE Python préféré, dans des *notebooks* ou même dans Google Colab 🤯 !

-Alors installez *Gradio* partout où vous exécutez Python !

-

-Commençons par un exemple simple de type « *Hello World* » pour nous familiariser avec la syntaxe de *Gradio* :

-

-```py

-import gradio as gr

-

-

-def greet(name):

- return "Hello " + name

-

-

-demo = gr.Interface(fn=greet, inputs="text", outputs="text")

-

-demo.launch()

-```

-

-Parcourons le code ci-dessus :

-

-- D'abord, nous définissons une fonction appelée `greet()`. Dans ce cas, c'est une simple fonction qui ajoute « *Hello* » devant votre nom, mais cela peut être *n'importe quelle* fonction Python en général. Par exemple, dans les applications d'apprentissage automatique, cette fonction pourrait *appeler un modèle pour faire une prédiction* sur une entrée et retourner la sortie.

-- Ensuite, nous créons une `Interface` *Gradio* avec trois arguments, `fn`, `inputs`, et `outputs`. Ces arguments définissent la fonction de prédiction, ainsi que le _type_ de composants d'entrée et de sortie que nous souhaitons. Dans notre cas, les deux composants sont de simples boîtes de texte.

-- Nous appelons ensuite la méthode `launch()` sur l'`Interface` que nous avons créée.

-

-Si vous exécutez ce code, l'interface ci-dessous apparaîtra automatiquement dans un *notebook* Jupyter/Colab ou dans un navigateur sur **[http://localhost:7860](http://localhost:7860/)** si vous l'exécutez à partir d'un script.

-

-

-

-Essayez d'utiliser cette interface maintenant avec votre propre nom ou une autre entrée !

-

-Vous remarquerez que dedans, *Gradio* a automatiquement déduit le nom du paramètre d'entrée (`name`) et l'a appliqué comme étiquette au dessus de la zone de texte. Que faire si vous souhaitez changer cela ?

-Ou si vous souhaitez personnaliser la zone de texte d'une autre manière ? Dans ce cas, vous pouvez instancier un objet de classe représentant le composant de saisie.

-

-Jetez un coup d'œil à l'exemple ci-dessous :

-

-```py

-import gradio as gr

-

-

-def greet(name):

- return "Hello " + name

-

-

-# Nous instancions la classe Textbox

-textbox = gr.Textbox(label="Type your name here:", placeholder="John Doe", lines=2)

-

-gr.Interface(fn=greet, inputs=textbox, outputs="text").launch()

-```

-

-

-

-Ici, nous avons créé une zone de texte d'entrée avec une étiquette, un espace réservé et un nombre de lignes défini.

-Vous pourriez faire la même chose pour la zone de texte de sortie, mais nous allons laisser cela pour le moment.

-

-Nous avons vu qu'avec seulement quelques lignes de code, *Gradio* vous permet de créer une interface simple autour de n'importe quelle fonction

-avec n'importe quel type d'entrées ou de sorties. Dans cette section, nous avons commencé par une simple boîte de texte mais dans les sections suivantes, nous couvrirons d'autres types d'entrées et de sorties. Voyons maintenant comment inclure un peu de NLP dans une application *Gradio*.

-

-

-## 🤖 Inclure les prédictions du modèle

-

-Construisons maintenant une interface simple qui permet de faire une démo d'un modèle de **génération de texte** comme le GPT-2.

-

-Nous allons charger notre modèle en utilisant la fonction `pipeline()` de 🤗 *Transformers*.

-Si vous avez besoin d'un rafraîchissement rapide, vous pouvez revenir à [cette section du chapitre 1](/course/fr/chapter1/3#text-generation).

-

-Tout d'abord, nous définissons une fonction de prédiction qui prend une invite de texte et renvoie la complétion du texte :

-

-```py

-from transformers import pipeline

-

-model = pipeline("text-generation")

-

-

-def predict(prompt):

- completion = model(prompt)[0]["generated_text"]

- return completion

-```

-

-Cette fonction complète le texte que vous fournissez, et vous pouvez l'exécuter avec les votres pour voir comment elle fonctionne. Voici un exemple (vous obtiendrez peut-être un résultat différent) :

-

-

-```

-predict("My favorite programming language is") # Mon langage de programmation préféré est

-```

-

-```

->> My favorite programming language is Haskell. I really enjoyed the Haskell language, but it doesn't have all the features that can be applied to any other language. For example, all it does is compile to a byte array.

-# Mon langage de programmation préféré est Haskell. J'ai vraiment apprécié le langage Haskell, mais il n'a pas toutes les caractéristiques que l'on peut appliquer à n'importe quel autre langage. Par exemple, il ne fait que compiler un tableau d'octets.

-```

-

-Maintenant que nous avons une fonction pour générer des prédictions, nous pouvons créer et lancer une `Interface` de la même manière que nous l'avons fait précédemment :

-

-```py

-import gradio as gr

-

-gr.Interface(fn=predict, inputs="text", outputs="text").launch()

-```

-

-

-C'est fait ! Vous pouvez maintenant utiliser cette interface pour générer du texte en utilisant le modèle GPT-2 comme indiqué ci-dessous 🤯.

-

-

-

-Continuez votre lecture du cours pour voir comment construire d'autres types de démos avec *Gradio* !

+# Construire votre première démo

+

+

+

+Commençons par installer *Gradio* ! Comme il s'agit d'un *package* Python, il suffit de l'exécuter :

+

+`$ pip install gradio `

+

+Vous pouvez exécuter *Gradio* n'importe où, que ce soit dans votre IDE Python préféré, dans des *notebooks* ou même dans Google Colab 🤯 !

+Alors installez *Gradio* partout où vous exécutez Python !

+

+Commençons par un exemple simple de type « *Hello World* » pour nous familiariser avec la syntaxe de *Gradio* :

+

+```py

+import gradio as gr

+

+

+def greet(name):

+ return "Hello " + name

+

+

+demo = gr.Interface(fn=greet, inputs="text", outputs="text")

+

+demo.launch()

+```

+

+Parcourons le code ci-dessus :

+

+- D'abord, nous définissons une fonction appelée `greet()`. Dans ce cas, c'est une simple fonction qui ajoute « *Hello* » devant votre nom, mais cela peut être *n'importe quelle* fonction Python en général. Par exemple, dans les applications d'apprentissage automatique, cette fonction pourrait *appeler un modèle pour faire une prédiction* sur une entrée et retourner la sortie.

+- Ensuite, nous créons une `Interface` *Gradio* avec trois arguments, `fn`, `inputs`, et `outputs`. Ces arguments définissent la fonction de prédiction, ainsi que le _type_ de composants d'entrée et de sortie que nous souhaitons. Dans notre cas, les deux composants sont de simples boîtes de texte.

+- Nous appelons ensuite la méthode `launch()` sur l'`Interface` que nous avons créée.

+

+Si vous exécutez ce code, l'interface ci-dessous apparaîtra automatiquement dans un *notebook* Jupyter/Colab ou dans un navigateur sur **[http://localhost:7860](http://localhost:7860/)** si vous l'exécutez à partir d'un script.

+

+

+

+Essayez d'utiliser cette interface maintenant avec votre propre nom ou une autre entrée !

+

+Vous remarquerez que dedans, *Gradio* a automatiquement déduit le nom du paramètre d'entrée (`name`) et l'a appliqué comme étiquette au dessus de la zone de texte. Que faire si vous souhaitez changer cela ?

+Ou si vous souhaitez personnaliser la zone de texte d'une autre manière ? Dans ce cas, vous pouvez instancier un objet de classe représentant le composant de saisie.

+

+Jetez un coup d'œil à l'exemple ci-dessous :

+

+```py

+import gradio as gr

+

+

+def greet(name):

+ return "Hello " + name

+

+

+# Nous instancions la classe Textbox

+textbox = gr.Textbox(label="Type your name here:", placeholder="John Doe", lines=2)

+

+gr.Interface(fn=greet, inputs=textbox, outputs="text").launch()

+```

+

+

+

+Ici, nous avons créé une zone de texte d'entrée avec une étiquette, un espace réservé et un nombre de lignes défini.

+Vous pourriez faire la même chose pour la zone de texte de sortie, mais nous allons laisser cela pour le moment.

+

+Nous avons vu qu'avec seulement quelques lignes de code, *Gradio* vous permet de créer une interface simple autour de n'importe quelle fonction

+avec n'importe quel type d'entrées ou de sorties. Dans cette section, nous avons commencé par une simple boîte de texte mais dans les sections suivantes, nous couvrirons d'autres types d'entrées et de sorties. Voyons maintenant comment inclure un peu de NLP dans une application *Gradio*.

+

+

+## 🤖 Inclure les prédictions du modèle

+

+Construisons maintenant une interface simple qui permet de faire une démo d'un modèle de **génération de texte** comme le GPT-2.

+

+Nous allons charger notre modèle en utilisant la fonction `pipeline()` de 🤗 *Transformers*.

+Si vous avez besoin d'un rafraîchissement rapide, vous pouvez revenir à [cette section du chapitre 1](/course/fr/chapter1/3#text-generation).

+

+Tout d'abord, nous définissons une fonction de prédiction qui prend une invite de texte et renvoie la complétion du texte :

+

+```py

+from transformers import pipeline

+

+model = pipeline("text-generation")

+

+

+def predict(prompt):

+ completion = model(prompt)[0]["generated_text"]

+ return completion

+```

+

+Cette fonction complète le texte que vous fournissez, et vous pouvez l'exécuter avec les votres pour voir comment elle fonctionne. Voici un exemple (vous obtiendrez peut-être un résultat différent) :

+

+

+```

+predict("My favorite programming language is") # Mon langage de programmation préféré est

+```

+

+```

+>> My favorite programming language is Haskell. I really enjoyed the Haskell language, but it doesn't have all the features that can be applied to any other language. For example, all it does is compile to a byte array.

+# Mon langage de programmation préféré est Haskell. J'ai vraiment apprécié le langage Haskell, mais il n'a pas toutes les caractéristiques que l'on peut appliquer à n'importe quel autre langage. Par exemple, il ne fait que compiler un tableau d'octets.

+```

+

+Maintenant que nous avons une fonction pour générer des prédictions, nous pouvons créer et lancer une `Interface` de la même manière que nous l'avons fait précédemment :

+

+```py

+import gradio as gr

+

+gr.Interface(fn=predict, inputs="text", outputs="text").launch()

+```

+

+

+C'est fait ! Vous pouvez maintenant utiliser cette interface pour générer du texte en utilisant le modèle GPT-2 comme indiqué ci-dessous 🤯.

+

+

+

+Continuez votre lecture du cours pour voir comment construire d'autres types de démos avec *Gradio* !

diff --git a/chapters/fr/chapter9/3.mdx b/chapters/fr/chapter9/3.mdx

index caabfd317..74388c76f 100644

--- a/chapters/fr/chapter9/3.mdx

+++ b/chapters/fr/chapter9/3.mdx

@@ -1,168 +1,168 @@

-# Comprendre la classe Interface

-

-

-

-Dans cette section, nous allons examiner de plus près la classe `Interface`, et comprendre les principaux paramètres utilisés pour en créer une.

-

-## Comment créer une interface

-

-Vous remarquerez que la classe `Interface` a 3 paramètres obligatoires :

-

-`Interface(fn, inputs, outputs, ...)`

-

-Ces paramètres sont :

-

- - `fn`: la fonction de prédiction qui est enveloppée par l'interface *Gradio*. Cette fonction peut prendre un ou plusieurs paramètres et retourner une ou plusieurs valeurs.

- - `inputs`: le(s) type(s) de composant(s) d'entrée. *Gradio* fournit de nombreux composants préconstruits tels que`"image"` ou `"mic"`.

- - `outputs`: le(s) type(s) de composant(s) de sortie. Encore une fois, *Gradio* fournit de nombreux composants pré-construits, par ex. `"image"` ou `"label"`.

-

-Pour une liste complète des composants, [jetez un coup d'œil à la documentation de *Gradio*](https://gradio.app/docs). Chaque composant préconstruit peut être personnalisé en instanciant la classe correspondant au composant.

-

-Par exemple, comme nous l'avons vu dans la [section précédente](/course/fr/chapter9/2), au lieu de passer le paramètre `inputs` par `"textbox"`, vous pouvez passer un composant `Textbox(lines=7, label="Prompt")` pour créer une zone de texte avec 7 lignes et un label.

-

-Voyons un autre exemple, cette fois avec un composant `Audio`.

-

-## Un exemple simple avec audio

-

-Comme mentionné précédemment, *Gradio* fournit de nombreuses entrées et sorties différentes.

-Construisons donc une `Interface` qui fonctionne avec l'audio.

-

-Dans cet exemple, nous allons construire une fonction audio-vers-audio qui prend un fichier audio et l'inverse simplement.

-

-Nous utiliserons comme entrée le composant `Audio`. Lorsque vous utilisez le composant `Audio`, vous pouvez spécifier si vous voulez que la `source` de l'audio soit un fichier que l'utilisateur télécharge ou un microphone avec lequel l'utilisateur enregistre sa voix. Dans ce cas, nous allons choisir un microphone. Juste pour le plaisir, nous allons ajouter une étiquette à notre `Audio` qui dit « *Speak here...* » (Parler ici).

-

-De plus, nous aimerions recevoir l'audio sous la forme d'un tableau numpy afin de pouvoir facilement l'inverser. Nous allons donc définir le `"type"` comme étant `"numpy"`, ce qui permet de passer les données d'entrée comme un *tuple* de (`sample_rate`, `data`) dans notre fonction.

-

-Nous utiliserons également le composant de sortie `Audio` qui peut automatiquement rendre un *tuple* avec un taux d'échantillonnage et un tableau numpy de données comme un fichier audio lisible.

-Dans ce cas, nous n'avons pas besoin de faire de personnalisation, donc nous utiliserons le raccourci de la chaîne `"audio"`.

-

-

-```py

-import numpy as np

-import gradio as gr

-

-

-def reverse_audio(audio):

- sr, data = audio

- reversed_audio = (sr, np.flipud(data))

- return reversed_audio

-

-

-mic = gr.Audio(source="microphone", type="numpy", label="Speak here...")

-gr.Interface(reverse_audio, mic, "audio").launch()

-```

-

-Le code ci-dessus produira une interface comme celle qui suit (si votre navigateur ne vous demande pas l'autorisation pour accéder au microphone, ouvrez la démo dans un onglet séparé).

-

-

-